-

腾讯研发全球首个大熊猫模型:实时识别、统计、分析大熊猫行为并生成报告

腾讯 10 月 25 日宣布,为了帮助饲养员全方位观察大熊猫,腾讯、中国大熊猫保护研究中心、广东工业大学,联合打造了全球首个大熊猫行为智能识别模型及智慧系统。 该模型可以识别大熊猫进食、喝水、睡觉等日常行为,并自动生成日报、周报、月报等可视化数据报表。项目组通过优化 SlowFast 算法,大幅提升了系统在遮挡环境下的行为识别能力,目前室内遮挡场景下的大熊猫行为识别准确率提升到了 80% 以上。 …- 2.7k

-

阿尔特曼回应 OpenAI 计划推出下一代模型 Orion:假消息失控了

10 月 25 日消息,昨日午间,OpenAI 首席执行官山姆・阿尔特曼在 X 平台回应了近期有关“下一代模型 Orion”的报道:fake news out of control(假消息失控了)。 附前情提要: 今天早些时候有外媒报道称,OpenAI 计划今年 12 月推出代号为“Orion”的新款前沿模型。“Orion”采用有别于 GPT-4o 和 o1 的发布模式,不会通过 ChatGPT …- 2.3k

-

全球最强模型:OpenAI 被曝 12 月推出 Orion,AI 性能百倍级跃升

科技媒体 The Verge 今天(10 月 25 日)发布博文,报道称 OpenAI 计划今年 12 月推出代号为“Orion”的新款前沿模型。 该媒体报道,“Orion”采用有别于 GPT-4o 和 o1 的发布模式,不会通过 ChatGPT 广泛发布,而是先授权与其密切合作的公司,帮其构建自己的产品和功能。 此外消息源还表示微软内部工程师正在准备最早于 11 月在 Azure 上托管“Ori…- 2.4k

-

智谱发布新一代基础模型,清言App 国内率先面向 C 端开放视频通话服务

智谱 AI 在 KDD 2024 大会上发布了新一代基础模型,自称在相应领域均达到了国际第一梯队的水准,并宣布在 MaaS 平台上免费开放 GLM-4-Flash API: 语言模型 GLM-4-Plus:在语言理解、指令遵循、长文本处理等方面性能得到全面提升。 文生图模型 CogView-3-Plus:具备与当前最上面的 MJ-V6 和 FLUX 等模型接近的性能。 图像 / 视频理解模型 GL…- 5.7k

-

小而强悍!10人团队炼出首个微调Llama 3.1 405B

一个仅有10人的小团队,竟然敢挑战科技巨头Meta的地位,这简直就是现实版的"大卫战胜歌利亚"! 这个名叫Nous Research的初创公司可不是什么无名之辈。他们刚刚推出的Hermes3,是基于Llama3.1的405B模型微调而成的。别看团队人数少,但他们的实力可不容小觑。这个"十人天团"已经成功微调了Mistral、Yi、Llama等多个模型,下载量…- 5.1k

-

谷歌发布全新Gemma 2 2B模型,性能超越GPT-3.5-Turbo与Mixtral-8x7B

谷歌正式推出了其 Gemma2系列的新成员 ——Gemma22B 模型。这个拥有20亿参数的模型,展现出了在多种硬件环境下的卓越性能。除了强大的模型本身,谷歌还推出了 ShieldGemma 安全分类器,以过滤有害内容,并提供 Gemma Scope 工具,供研究人员分析模型的决策过程。 Gemma22B 在 “聊天机器人竞技场” 排行榜上的表现尤为抢眼,以1130的高分,成功超越了包括 GPT-…- 2.9k

-

智谱 AI宣布GLM-4-9B、CodeGeeX4-ALL-9B 支持 Ollama 部署

智谱 AI宣布GLM-4-9B和CodeGeeX4-ALL-9B模型现在支持通过Ollama进行部署。 GLM-4-9B是智谱AI推出的开源预训练模型,属于GLM-4系列,它在语义、数学、推理、代码和知识等多方面展现出卓越的能力。 CodeGeeX4-ALL-9B是在GLM-4-9B基础上训练的多语言代码生成模型,进一步提升了代码生成能力。 Ollama是一个工具,专为本地环境中运行和定制大型语言…- 4.8k

-

Meta AI为移动设备开发紧凑型语言模型MobileLLM,仅3.5亿参数

Meta AI 研究人员推出了 MobileLLM,这是一种为智能手机和其他资源受限的设备设计高效语言模型的新方法。这项研究于2024年6月27日发布,挑战了有关有效 AI模型必要规模的假设。 该研究团队由 Meta Reality Labs、PyTorch 和 Meta AI Research (FAIR) 的成员组成,专注于优化参数少于10亿的模型。这只是 GPT-4等模型的一小部分,据估计,…- 5.6k

-

B站开源轻量级 Index-1.9B 系列模型:2.8T 训练数据,支持角色扮演

B站昨日开源了轻量级 Index-1.9B 系列模型,包含基座模型、对照组、对话模型、角色扮演模型等多个版本。 官方简介: Index-1.9B base : 基座模型,具有 19 亿非词嵌入参数量,在 2.8T 中英文为主的语料上预训练,多个评测基准上与同级别模型比处于领先。 Index-1.9B pure : 基座模型的对照组,与 base 具有相同的参数和训练策略,不同之处在于严格过滤了该版…- 7.1k

-

stable diffusion写实真人大模型推荐,极致摄影,大片质感

今天和大家分享一个之前在很多文章里面使用到的基于SD1.5的写实大模型:墨幽人造人。当时使用该模型的版本是V1030, 在LiblibAI网站模型首页有过一段这样的介绍。 墨幽人造人,不只是人造人。 她是一个全功能的综合模型,她包含真实的一切。 她拥有着极强的各类lora兼容性,并且还是一个用来训练真实系lora的绝佳底模。 她可以是女人,也可以是男人,她还可以是各种动物、或是想象中的物种。 她是…- 8.5k

-

阿里巴巴开源 1100 亿参数 Qwen1.5-110B 模型,与 Meta Llama3-70B 相媲美

阿里巴巴日前宣布,开源 Qwen1.5 系列首个千亿参数模型 Qwen1.5-110B,该模型在基础能力评估中与 Meta-Llama3-70B 相媲美,在 Chat 评估中表现出色,包括 MT-Bench 和 AlpacaEval 2.0。 主要内容: 据介绍,Qwen1.5-110B 与其他 Qwen1.5 模型相似,采用了相同的 Transformer 解码器架构。它包含了分组查询注意力(G…- 1.5k

-

开源大模型DBRX:1320亿参数,比Llama2-70B快1倍

大数据公司Databricks最近发布了一款名为DBRX的MoE大模型,引发了开源社区的热议。DBRX在基准测试中击败了Grok-1、Mixtral等开源模型,成为了新的开源之王。这款模型的总参数量达到了1320亿,但每次激活只有360亿参数,并且其生成速度比Llama2-70B快1倍。 DBRX是由16个专家模型组成,每次推理有4个专家处于激活状态,上下文长度为32K。为了训练DBRX,Data…- 2.2k

-

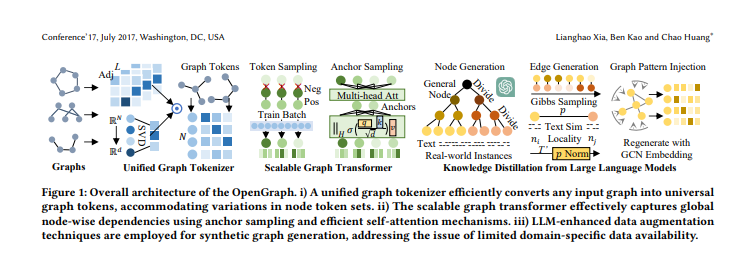

港大开源OpenGraph:攻克图基础模型难题,实现多领域通用图模型

近期,香港大学发布了OpenGraph,这是一项突破性的成果,成功攻克了图基础模型领域的三大难题。该模型通过巧妙的技术实现了零样本学习,可以适配多种下游任务。OpenGraph的构建主要分为统一图Tokenizer、可扩展的图Transformer和大语言模型知识蒸馏三个部分。 OpenGraph通过创建统一的图Tokenizer解决了不同数据集之间节点集合和特征空间的变化问题。采用拓扑感知映射方…- 4.4k

-

李开复旗下 AI 公司零一万物宣布开源 Yi-9B 模型,号称同系列代码、数学能力最强

“零一万物 01AI”官方公众号今晚发文宣布开源 Yi-9B 模型,官方称其为 Yi 系列模型中的“理科状元”——Yi-9B 是目前 Yi 系列模型中代码和数学能力最强的模型,实际参数为 8.8B,默认上下文长度为 4K tokens。 该模型是在 Yi-6B (使用了 3.1T tokens 训练)的基础上,使用了 0.8T tokens 进行继续训练,数据截至 2023 年 6 月。 据介绍,…- 3.1k

-

印度提出新要求:科技公司发布生成式AI工具之前,需获得政府许可

据路透社、外媒 TechCrunch 北京时间今日报道,印度信息技术部于当地时间上周五发布公告:各家科技公司在发布生成式 AI相关工具、新的模型之前,需要获得印度政府的明确许可。 图源 Pixabay TechCrunch 获得了这份文件的部分内容,其要求科技公司确保自己的服务或产品“不允许任何偏见或歧视”。该文件在法律上并不具有约束力,但印度信息技术部副部长拉吉夫・钱德拉塞卡尔表示,该通知“在示…- 1.3k

❯

搜索

扫码打开当前页

返回顶部

幸运之星即将降临……

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠

-

¥優惠使用時效:无法使用使用時效:

之前

使用時效:预期有效优惠编号:×

没有优惠可用!