-

元象发布中国最大 MoE 开源大模型:总参数 255B,激活参数 36B

元象 XVERSE 发布中国最大 MoE 开源模型 XVERSE-MoE-A36B。 该模型总参数 255B,激活参数 36B,官方号称效果能“大致达到”超过 100B 大模型的“跨级”性能跃升,同时训练时间减少 30%,推理性能提升 100%,使每 token 成本大幅下降。 MoE(Mixture of Experts)混合专家模型架构,将多个细分领域的专家模型组合成一个超级模型,在扩大模型规…- 6.1k

-

元象发布 XVERSE-MoE-A4.2B 大模型 可免费商用

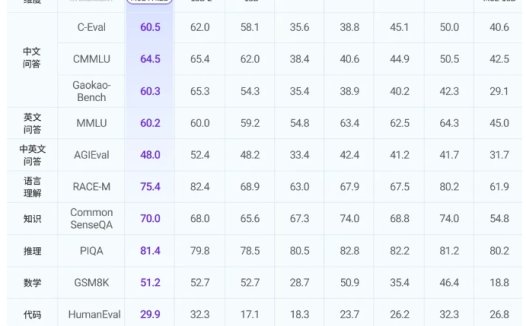

元象发布了 XVERSE-MoE-A4.2B 大模型,采用混合专家模型架构,激活参数为4.2B,效果媲美13B 模型。该模型全开源,免费商用,可用于海量中小企业、研究者和开发者,推动低成本部署。 该模型具有极致压缩和超凡性能两大优势,采用稀疏激活技术,效果超越多个业界顶流模型,并接近超大模型。元象 MoE 技术自研创新,研发高效融合算子、细粒度专家设计、负载均衡损失项等,最终采用实验4对应的架构设…- 4.9k

-

元象大模型开源30款量化版本 可更低成本部署

元象大模型开源了30款量化版本,支持 vLLM 和 llama.cpp 等主流框架的量化推理,无条件免费商用。 对量化前后的模型能力、推理性能进行评估,以 XVERSE-13B-GPTQ-Int4量化版本为例,量化后模型权重压缩了72%,总吞吐提高了1.5倍,同时保留了95% 的能力。 开发者可以根据技能、软硬件配置和具体需求选择不同推理框架和数据精度的模型。如果本地资源有限,可以直接调用元象大模…- 3.5k

❯

搜索

扫码打开当前页

返回顶部

幸运之星即将降临……

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠

-

¥優惠使用時效:无法使用使用時效:

之前

使用時效:预期有效优惠编号:×

没有优惠可用!