-

Sand AI 发布开源视频生成模型 MAGI-1,清华特奖得主团队视频生成AI一夜刷屏

视频生成领域,又出现一位重量级开源选手。 2025 年 4 月 21 日,马尔奖、清华特奖得主曹越的创业公司 Sand AI 推出了自己的视频生成大模型 ——MAGI-1。这是一个通过自回归预测视频块序列来生成视频的世界模型,生成效果自然流畅,还有多个版本可以下载。 根据官方介绍,MAGI-1 生成的视频具有以下特点: 1、流畅度高,不卡顿,可以无限续写。它可以一镜到底生成连续的长视…- 1.4k

-

谷歌 Veo 2 视频生成模型入驻 Gemini,用户可创建 8 秒 720p 视频

4 月 16 日消息,谷歌宣布将旗下的 Veo 2 视频生成 AI 模型带给 Gemini Advanced 订阅用户。这一举措旨在应对 OpenAI 的 Sora 视频生成平台的竞争,并在日益激烈的市场中占据一席之地。就在两周前,合成媒体领域的强劲对手 Runway 发布了其第四代视频生成器,并成功筹集了超过 3 亿美元(注:现汇率约合 21.93 亿元人民币)的新资金。 从本周二开始,Gemi…- 582

-

快手发布可灵 2.0 视频生成模型及可图 2.0 图像生成模型

4 月 15 日消息,快手今日举行“灵感成真”可灵 AI 2.0 模型发布会,并宣布基座模型再次升级,面向全球正式发布可灵 2.0 视频生成模型及可图 2.0 图像生成模型。 据介绍,可灵 2.0 模型在动态质量、语义响应、画面美学等维度,保持全球领先;可图 2.0 模型在指令遵循、电影质感及艺术风格表现等方面显著提升。 快手高级副总裁、社区科学线负责人盖坤透露,自去年 6 月发布以来,可灵 AI…- 1.5k

-

Runway 发布 AI 视频生成模型 Gen-4:可保持角色、场景高度一致性

4 月 1 日消息,人工智能(AI)初创公司 Runway 于本周一发布了其最新研发的 AI 视频生成模型 Gen-4。该公司声称,这是目前为止保真度最高的 AI 驱动视频生成工具之一。 新发布的 Gen-4 模型现已开始向 Runway 的个人及企业客户推送。据 Runway 介绍,该模型的核心优势在于能够在不同的视频场景中保持角色、地点和物体的高度一致性,维持“连贯的世界环境”,并且能够从场景…- 1.6k

-

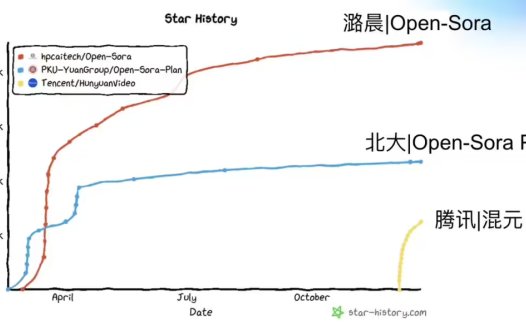

潞晨科技推出开源视频生成模型 Open-Sora 2.0,性能接近 OpenAI Sora

3 月 13 日消息,今日,潞晨科技宣布推出 Open-Sora2.0,并全面开源模型权重、推理代码及分布式训练全流程。 据介绍,这是一款新开源的 SOTA 视频生成模型,仅用 20 万美元(注:当前约 144.9 万元人民币),也就是 224 张 GPU 成功训练出商业级 11B 参数视频生成大模型,性能直追腾讯混元和 30B 参数的 Step-Video。 潞晨科技表示,从 Open-Sora…- 1.9k

-

最强开源视频模型?本地部署阿里的万象2.1(Wan2.1)文生视频

继腾讯混元之后,阿里也宣布开源旗下视频生成模型:万相2.1(Wan2.1),称其具有SOTA级别的性能,其亮点包括: 1、优于现有开源模型,甚至可以“与一些闭源模型相媲美”。 2、是第一个能够同时生成中英文文本的视频模型。 3、 支持消费级 GPU,其中T2V-1.3B模型仅需8.19GB显存。 目前万相2.1已可以通过ComfyUI本地部署,下面说一下方法: 一、安装必须工具 请保持“网络畅通”…- 17.2k

-

昆仑万维开源国内首个面向 AI短剧创作的视频生成模型 SkyReels-V1

2 月 18 日消息,昆仑万维今日宣布开源国内首个面向 AI短剧创作的视频生成模型 SkyReels-V1、国内首个 SOTA 级别基于视频基座模型的表情动作可控算法 SkyReels-A1。 昆仑万维官方介绍称,SkyReels-V1 针对表演细节做了打标,还对情绪、场景、表演诉求等进行处理,利用“千万级别、高质量”的好莱坞级别数据进行训练微调。 此外,SkyReels-V1 可实现“影视级人物…- 2.4k

-

OpenAI 称目前尚无推出视频生成模型 Sora API 的计划

12 月 18 日消息,OpenAI 今日表示,目前没有推出其视频生成模型 Sora 的应用程序接口(API)的计划,该模型可基于文本、图像生成视频。 在 OpenAI 开发团队成员的在线问答活动中,OpenAI 开发者体验负责人 Romain Huet 明确指出:“我们目前还没有推出 Sora API 的计划。” 此前,由于访问量远超预期,OpenAI 此前不得不紧急关闭了基于 Sora 的视频…- 2.1k

-

字节跳动豆包电脑版上线视频生成功能,内测用户每日可免费生成十支视频

字节跳动视频生成模型 PixelDance 已在豆包电脑版正式开启内测,部分用户已开通体验入口。内测页面显示,用户每日可免费生成十支视频。 据1AI此前报道,PixelDance 视频生成模型于 9 月底首次发布,最早通过即梦 AI、火山引擎面向创作者和企业客户小范围邀测。 据早期内测创作者介绍,当 PixelDance 生成 10 秒视频时,切换镜头 3-5 次的效果最佳,场景和角色能保持很好的…- 2.5k

-

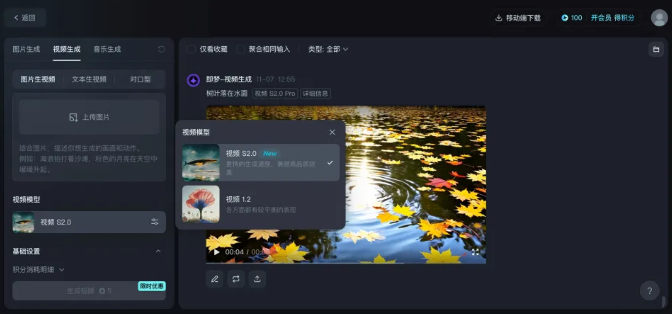

即梦AI宣布Seaweed视频生成模型开放使用

近日,即梦AI宣布,即日起由字节跳动自研的视频生成模型Seaweed面向平台用户正式开放。用户登陆后,在“视频生成”功能下,视频模型选择“视频S2.0”即可体验。 Seaweed视频生成模型是豆包模型家族的一部分,具备专业级光影布局及色彩调和,画面视觉极具美感和真实感。基于DiT架构,Seaweed视频生成模型还能实现大幅度运动画面流畅自然。 测试显示,该模型仅需60s就能生成时长5s的高质量AI…- 6.3k

-

阿里通义万相视频生成模型“AI生视频”功能正式上线,更懂中国风的大模型来了

在2024 阿里云栖大会上,阿里云CTO周靖人宣布,其最新研发的AI视频生成大模型—通义万相AI生视频,已正式上线,官网和App上都可以立刻试用了。 AI视频国内战场,阿里也下场了。 阿里巴巴旗下通义推出的通义万相AI生视频模型正式上线,具有强大的画面视觉动态生成能力,支持多种艺术风格和影视级质感的视频内容生成。 该模型优化了中式元素表现,支持多语言输入和可变分辨率生成,应用场景广泛,提供免费服务…- 11.6k

-

字节跳动豆包大模型 9 月 24 日发布视频生成模型

字节跳动火山引擎宣布,豆包大模型将在9月24日发布视频生成模型,并将带来更多模型家族的能力升级。 据了解,豆包大模型在2024年5月15日的火山引擎原动力大会上正式发布。 豆包大模型提供了多种版本,包括专业版和轻量版,以适应不同场景的需求。专业版支持128K长文本处理,具备强大的理解、生成和逻辑综合能力,适用于问答、总结、创作和分类等场景。而轻量版则提供更低的token成本和延迟,为企业提供了灵活…- 14.2k

-

Adobe Premiere Pro 将集成视频生成功能,年底前推出

Adobe 宣布,将于今年年底前推出由 Adobe Firefly Video 模型驱动的视频生成功能,届时用户可以在 Premiere Pro 测试版应用和独立网站上体验这一功能。 Adobe 表示目前正在内部测试三种功能:生成续帧 (Generative Extend)、文本转视频 (Text to Video) 和图像转视频 (Image to Video),并将在近期开放公测。 生成续帧功…- 2.5k

-

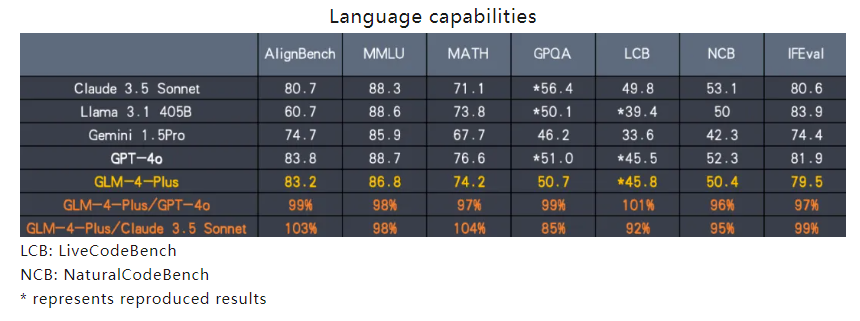

智谱AI发布GLM-4-Plus:媲美GPT-4,首创C端视频通话功能

智谱AI近日发布了其最新基座大模型GLM-4-Plus,展示了堪比OpenAI GPT-4的强大视觉能力,宣布于8月30日开放使用。 主要更新亮点: 语言基础模型GLM-4-Plus:在语言解析、指令执行和长文本处理能力上实现了质的飞跃,持续保持在国际竞争中的领先地位。 文生图模型CogView-3-Plus:性能与业界顶尖的MJ-V6和FLUX模型相媲美。 图像/视频理解模型GLM-4V-Plu…- 21.2k

-

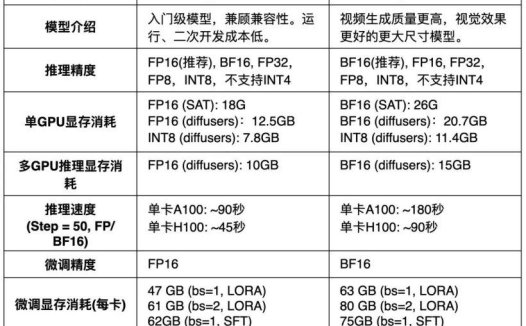

智谱AI 开源 CogVideoX-5B 视频生成模型,RTX 3060 显卡可运行

8 月 28 日消息,智谱AI 开源了 CogVideoX-5B 视频生成模型,相比此前开源的 CogVideoX-2B,官方称其视频生成质量更高,视觉效果更好。 官方表示大幅度优化了模型的推理性能,推理门槛大幅降低,可以在 GTX 1080Ti 等早期显卡运行 CogVideoX-2B ,在 RTX 3060 等桌面端“甜品卡”运行 CogVideoX-5B 模型。 CogVideoX 是一个大…- 12.3k

-

智谱AI宣布开源「清影」同源视频生成模型—CogVideoX

智谱 AI 今日宣布,将与“清影”同源的视频生成模型 ——CogVideoX 开源。 据介绍,CogVideoX 开源模型包含多个不同尺寸大小的模型,目前将开源 CogVideoX-2B,它在 FP-16 精度下的推理需 18GB 显存,微调则需要 40GB 显存,这意味着单张 4090 显卡即可进行推理,而单张 A6000 显卡即可完成微调。 CogVideoX-2B 的提示词上限为 226 个…- 9.3k

-

Runway 发布第三代视频生成模型,90 秒生成 10 秒片段

专为电影和图像内容创作者打造生成式 AI工具的公司 Runway 发布了 Gen-3 Alpha 视频生成模型。 附 Gen-3 Alpha 官方网站:https://runwayml.com/blog/introducing-gen-3-alpha/ Runway 表示,与其之前的旗舰视频模型 Gen-2 相比,该模型在生成速度和保真度方面有了“重大”改进,并且对生成视频的结构、风格和运动提供了…- 7.2k

-

马斯克再评OpenAI视频生成模型:“AI增强的人类将创造出最好的作品”

早些时候,OpenAI 发布了最新的视频生成模型 Sora,其能够根据用户输入的文本描述,生成一段视频内容。同时,OpenAI 还放出了数段演示视频,譬如摩登女郎在东京街头散步、长毛象行走在雪地里等等,1ai已进行详细报道。 随后,埃隆・马斯克多次对 OpenAI 的新模型发表了评价。推特网友“贝夫・杰索斯”转发了一段 Sora 的演示视频,配文声称“gg Pixar”,马斯克今天下午便在这条推文…- 3.9k

-

AI初创公司Runway推出“运动笔刷”功能,让你的图片动起来!

近日,AI初创公司Runway宣布旗下视频生成模型Gen-2上线了令人惊叹的“运动笔刷”功能。这一功能的推出代表了模型可控性迎来了一个重要里程碑。用户只需在图片中涂抹一个区域或主体,并为其选择一个方向和添加运动强度,运动笔刷就可以为用户的生成添加受控运动。 这项功能目前可免费试用,通常为125秒的免费额度,一次消耗约4秒。用户可以自己提供图片,或者直接使用Runway生成的图片。这一功能的推出为用…- 3.1k

-

Stability AI推出视频生成模型Stable Video Diffusion

Stability AI近日推出了名为Stable Video Diffusion的视频生成模型,该模型基于该公司现有的Stable Diffusion文本转图像模型,能够通过对现有图像进行动画化生成视频。与其他AI公司不同,Stable Video Diffusion在开源领域提供了少数几个视频生成模型之一。 然而,需要注意的是,该模型目前处于“研究预览”阶段,使用者必须同意特定的使用条款,明确…- 2.5k