-

可精准控图!腾讯混元文生图开源模型上线三款ControlNet插件

腾讯混元文生图大模型(HunyuanDiT)近日联合社区发布了三款新的可控制插件ControlNet,分别为tile(高清放大)、inpainting(图像修复与扩充)和lineart(线稿生图),进一步扩展了其ControlNet矩阵。这些插件的加入,使得混元DiT模型能够覆盖更广泛的应用场景,包括美术、创意、建筑、摄影、美妆和电商等80%的案例和场景,为全球企业和个人开发者、创作者提供了更精准…- 6.5k

-

OpenBuddy开源大语言模型团队发布Llama3.1-8B模型中文版

Meta最近发布了新一代开源模型系列Llama3.1,其中包括一个405B参数的版本,其性能接近甚至在某些基准测试中超越了GPT-4等闭源模型。Llama3.1-8B-Instruct是该系列中的一个8B参数版本,支持英语、德语、法语、意大利语、葡萄牙语、西班牙语、印地语和泰语,上下文长度高达131072tokens,知识截止日期更新至2023年12月。 为了增强Llama3.1-8B-Instr…- 7.2k

-

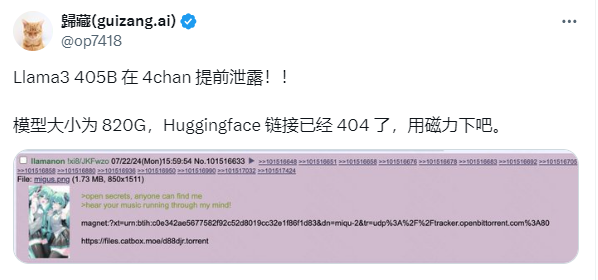

震惊AI界!Llama 3.1泄露:4050亿参数的开源巨兽来袭!

Llama3.1泄露了!你没听错,这个拥有4050亿参数的开源模型,已经在Reddit上引起了轩然大波。这可能是迄今为止最接近GPT-4o的开源模型,甚至在某些方面超越了它。 Llama3.1是由Meta(原Facebook)开发的大型语言模型。虽然官方还没有正式发布,但泄露的版本已经在社区引起了轰动。这个模型不仅包含了基础模型,还有8B、70B和最大参数的405B的基准测试结果。 性能对比:Ll…- 4.4k

-

DeepSeek开源DeepSeek-V2-Chat-0628模型 代码、数学推理能力提升

近日,LMSYS组织的大模型竞技场(Chatbot Arena)发布了最新的榜单更新,LMSYS Chatbot Arena 排行榜上总排名11超过了所有开源模型,包括Llama3-70B、Qwen2-72B、Nemotron-4-340B、Gemma2-27B等,荣获全球开源模型榜首的荣誉。 DeepSeek-V2-0628相较于0507开源 Chat 版本,在代码数学推理、指令跟随、角色扮演、…- 9k

-

支持中文的国产开源绘画AI大模型Kolors,ComfyUI平台部署指南

在AI技术的浪潮中,快手公司推出的文生图大模型——Kolors,以其卓越的性能和开源精神,成为国产AI技术的一颗璀璨新星。Kolors不仅在图像生成效果上超越了现有的开源模型,更达到了与商业闭源模型相媲美的水平,迅速在社交媒体上引发热议。 Kolors的开源之路 Kolors的开源不仅仅是一个技术里程碑,更是快手对AI技术开放态度的体现。在世界人工智能大会上,快手宣布Kolors正式开源,提供了包…- 12.8k

-

阿里云:通义千问API日调用量破亿 企业用户破9万

在今日的阿里云AI智领者峰会上,阿里云首席技术官(CTO)周靖人揭晓了一项令人瞩目的数据:通义千问的API日调用量已强势突破亿次大关,企业用户数也成功跃过9万家,开源模型下载量更是达到了惊人的700万次。 周靖人进一步详细介绍了通义千问在业界的专业表现。他指出,经过第三方机构的严格测评,通义千问在性能方面已经逐步接近并逼近GPT4,成为了行业的领军者。特别是在中文语境下的知识问答等方面,通义千问展…- 6.8k

-

可以在手机上用开源模型了!Hugging Face发布手机应用Hugging Chat

Hugging Face最近发布了一款名为“Hugging Chat”的iOS客户端应用,为用户带来了便捷。用户现在可以在手机上访问和使用Hugging Face平台上托管的各种开源模型。 下载地址:https://apps.apple.com/us/app/huggingchat/id6476778843 网页端地址:https://huggingface.co/chat 目前,该应用提供了六个…- 7.1k

-

Replicate:在线运行开源机器学习模型

Replicate是一个简化机器学习模型运行和部署的平台,让用户能够在云端大规模运行模型,而无需深入理解机器学习的工作原理。在这个网站内,可以直接去体验部署好的开源模型,如果是开发者,那么也可以用它来发布自己的模型。 核心功能 云端模型运行 Replicate 允许用户通过几行代码运行机器学习模型,包括通过 Python 库或直接查询 API。 大量现成模型 Replicate 的社区提供了数千个…- 10.2k

-

Databricks 推出 1320 亿参数大语言模型 DBRX,号称“现阶段最强开源 AI”

Databricks 近日在推出了一款通用大语言模型 DBRX,号称是“目前最强开源 AI”,据称在各种基准测试中都超越了“市面上所有的开源模型”。 从官方新闻稿中得知,DBRX 是一个基于 Transformer 的大语言模型,采用 MoE(Mixture of Experts)架构,具备 1320 亿个参数,并在 12T Token 的源数据上进行预训练。 研究人员对这款模型进行测试,相较于市…- 2.2k

-

阿里通义千问开源Qwen1.5-MoE-A2.7B模型

通义千问团队推出了 Qwen 系列的首个 MoE 模型,命名为 Qwen1.5-MoE-A2.7B。这个模型只有27亿个激活参数,但性能却与当前最先进的70亿参数模型相媲美。与 Qwen1.5-7B 相比,Qwen1.5-MoE-A2.7B 只有20亿个非嵌入参数,大约是原模型大小的三分之一。此外,相较于 Qwen1.5-7B,Qwen1.5-MoE-A2.7B 的训练成本降低了75%,推理速度提…- 2.8k

-

迷你AI模型TinyLlama发布:高性能、仅637MB

经过一番期待,TinyLlama项目发布了一款引人注目的开源模型。该项目于去年9月启动,开发人员致力于在数万亿标记上训练一款小型模型。在经历了一些辛勤工作和一些挫折之后,TinyLlama团队如今发布了这个模型。这个模型有着10亿个参数,大约在训练数据上进行了三个时代,或者说是通过训练数据的三个循环。 TinyLlama的最终版本在性能上超越了现有规模相当的开源语言模型,包括Pythia-1.4B…- 4.1k

❯

搜索

扫码打开当前页

返回顶部

幸运之星即将降临……

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠

-

¥優惠使用時效:无法使用使用時效:

之前

使用時效:预期有效优惠编号:×

没有优惠可用!