苹果公司旗下研究团队近日在 ArXiv 中公布了一篇名为《MM1:Methods, Analysis & Insights from Multimodal LLM Pre-training》的论文,其中介绍了一款 “MM1”多模态大模型,该模型提供 30 亿、70 亿、300 亿三种参数规模,拥有图像识别和自然语言推理能力。

苹果研究团队相关论文主要是利用 MM1 模型做实验,通过控制各种变量,找出影响模型效果的关键因素。

研究表明,图像分辨率和图像标记数量对模型性能影响较大,视觉语言连接器对模型的影响较小,不同类型的预训练数据对模型的性能有不同的影响。

据介绍,研究团队首先在模型架构决策和预训练数据上进行小规模消融实验。之后利用混合专家(Mixture of Experts)架构及一种名为 Top-2 Gating 的方法构建了 MM1 模型,号称不仅在预训练指标中实现了最好的性能表现,在一系列已有多模态基准上监督微调后也能保持有竞争力的性能。

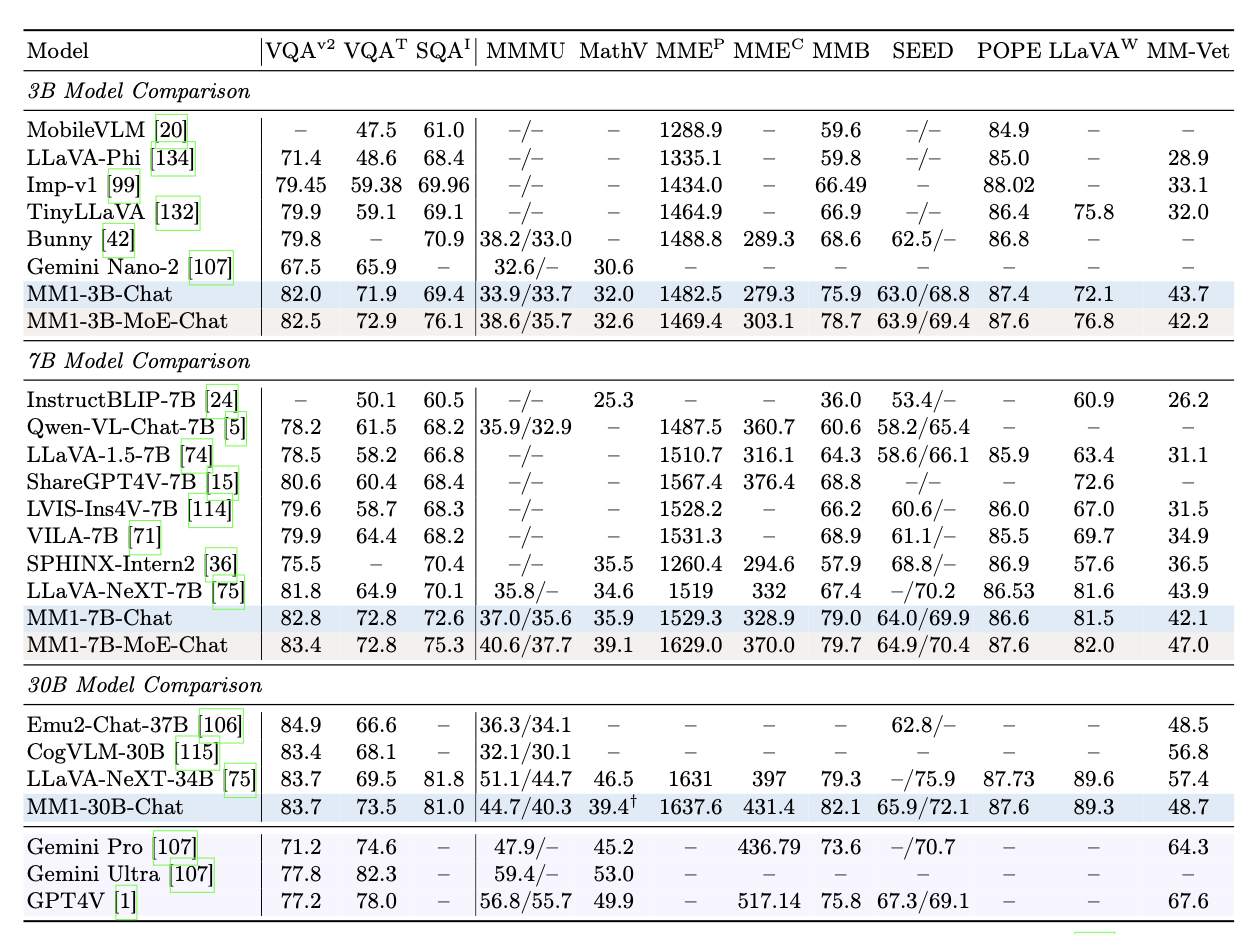

研究人员对“MM1”模型进行了测试,号称 MM1-3B-Chat 和 MM1-7B-Chat 优于市面上绝大多数相同规模的模型。MM1-3B-Chat 和 MM1-7B-Chat 在 VQAv2、TextVQA、ScienceQA、MMBench、MMMU 和 MathVista 中表现尤为突出,但是整体表现不如谷歌的 Gemini 和 OpenAI 的 GPT-4V。