继腾讯混元之后,阿里也宣布开源旗下视频生成模型:万相2.1(Wan2.1),称其具有SOTA级别的性能,其亮点包括:

1、优于现有开源模型,甚至可以“与一些闭源模型相媲美”。

2、是第一个能够同时生成中英文文本的视频模型。

3、 支持消费级 GPU,其中T2V-1.3B模型仅需8.19GB显存。

目前万相2.1已可以通过ComfyUI本地部署,下面说一下方法:

一、安装必须工具

请保持“网络畅通”,并确保已安装Python、Git,以及ComfyUI最新版(如果没有,安装方法参考此文章的后半部分:ComfyUI最新版安装)。

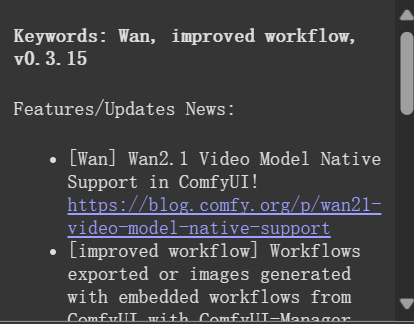

更新ComfyUI到最新版后,主界面可以看到已支持万相2.1的信息:

二、下载模型

接着下载模型,分四个部分。

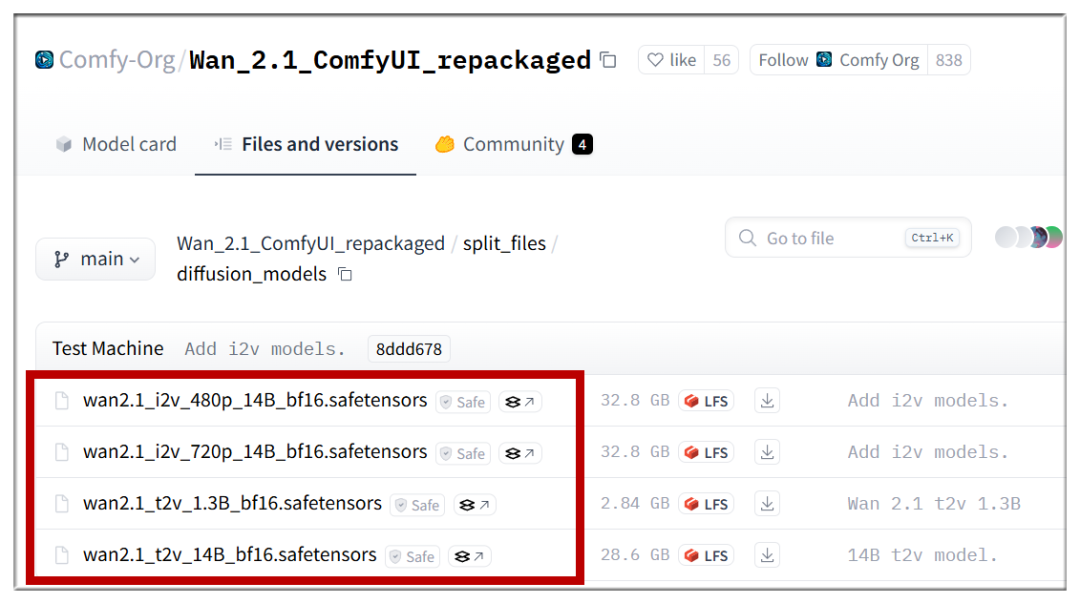

1、打开网址:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/diffusion_models

上述模型请根据需要下载,全部下载容量超过80GB。

2、下载下面的文件,并放入ComfyUI/models/text_encoders 目录

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/resolve/main/split_files/text_encoders/umt5_xxl_fp8_e4m3fn_scaled.safetensors?download=true

3、下载下面的文件,并放入ComfyUI/models/clip_vision 目录

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/resolve/main/split_files/clip_vision/clip_vision_h.safetensors?download=true

4、下载下面的文件,并放入ComfyUI/models/vae 目录

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/resolve/main/split_files/vae/wan_2.1_vae.safetensors?download=true

三、下载工作流

接下来到工作流页面,下载三个工作流,网址如下:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/example%20workflows_Wan2.1

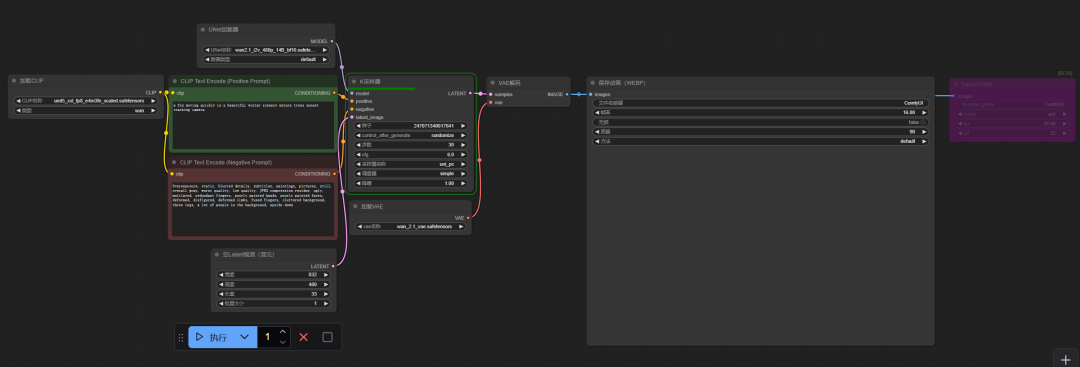

将工作流拖动到ComfyUI界面即可加载,你将看到类似下面这样的界面:

四、基本功能测试

到这里安装完成,首先来测试文生视频(使用T2V-14B)。

提示词:一个维多利亚的秘密的大胸模特,穿着红色的细小的比基尼,面带笑容在地中海沙滩上,远处的海面有几艘游艇,天空湛蓝,有少许白云

提示词:一个维多利亚的秘密的大胸模特,穿着红色的细小的比基尼,在地中海沙滩上,她面带笑容举着一块牌子,上面写着“welcome”

提示词:一个维多利亚的秘密的大胸模特,穿着红色的细小的比基尼,在地中海沙滩上,她面带笑容举着一块牌子,上面写着“我爱中国”

继续测试图生视频(使用I2V-14B-480P),使用这张图:

提示词:一个女孩在车里笑着说话,窗外车辆在移动

ComfyUI官方暂未提供视频生视频(使用T2V-14B),但kijai大佬制作的工作流已支持,这里就用刚生成的视频,修改画面中的人物。

提示词:一个半机械女孩坐在车里

注:kijai的工作流和模型需另行下载,详情参看推文底部代码页链接。

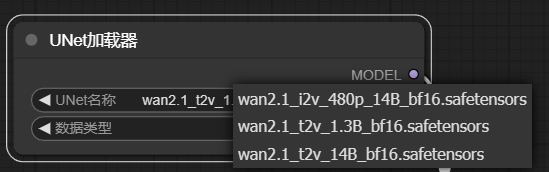

另外需要注意,因为万相2.1涉及多个模型,生成之前请在ComfyUI对话框里,确认你选择了正确的模型:

五、初步测试结论

1、从效果来看,阿里万相2.1不逊于腾讯混元,对提示词的遵从度也较好。

2、确实可生成中文,但只有部分情况能得到正确结果,需抽卡。

3、运行速度,在4090上运行文生视频(T2V-14B模型),大约8分钟可生成5秒480P视频(无量化等技术),使用T2V-1.3B则只要2分钟左右,但要牺牲效果。图生视频(I2V)速度更快,4090上生成5秒视频大约在3分钟。

4、文生视频可根据硬件选择1.3B和14B模型,图生视频只能选择14B模型,分辨率可选480P和720P。

文章涉及的网址

万相2.1官方代码页:

https://github.com/Wan-Video/Wan2.1

万相2.1 ComfyUI官方支持页面:

https://blog.comfy.org/p/wan21-video-model-native-support

万相2.1 ComfyUI代码页(kijai):

https://github.com/kijai/ComfyUI-WanVideoWrapper