11月9日消息,据外电报道,OpenAI 另一位首席安全研究员 Lilian Weng 周五宣布她将离开这家初创公司。Weng 自 8 月起担任研究和安全副总裁,在此之前,她曾担任 OpenAI 安全系统团队负责人。

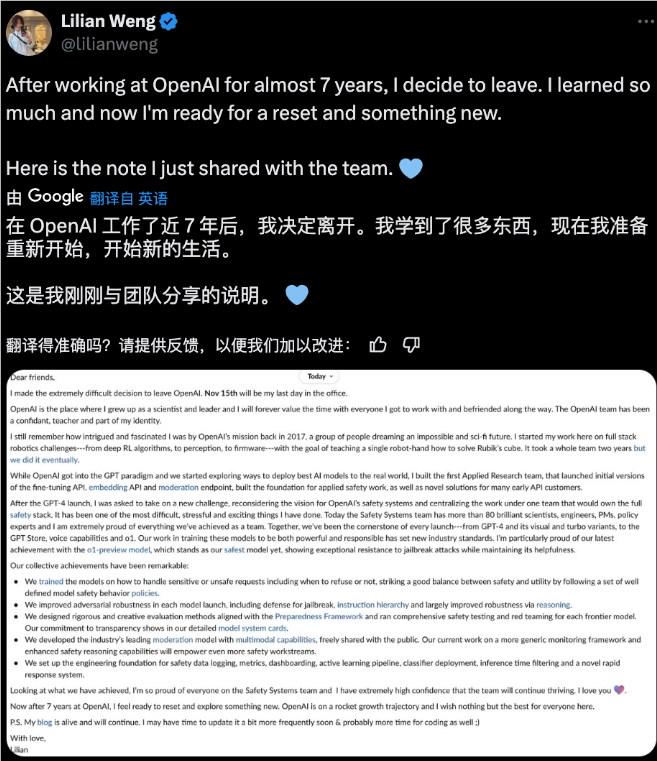

在X 上的一篇帖子中,翁女士表示,「在 OpenAI 工作了 7 年后,我感觉已经准备好重启并探索一些新的东西了。」

翁女士表示,她的最后一天将是 11 月 15 日,但没有具体说明她接下来会去哪里。

「我做出了离开 OpenAI 的极其艰难的决定。」Weng 在帖子中说道。「看看我们所取得的成就,我为安全系统团队的每个人都感到骄傲,我非常有信心团队将继续蓬勃发展。」

翁的离职是去年一系列人工智能安全研究人员、政策研究人员和其他高管离开 OpenAI 的最新一员,其中几人指责OpenAI 优先考虑商业产品而非人工智能安全。

翁的离职与Ilya Sutskever和Jan Leike一起,他们是 OpenAI 现已解散的Superalignment 团队的负责人,该团队试图开发控制超级智能 AI 系统的方法,他们今年也离开了这家初创公司,转而从事其他人工智能安全工作。

根据翁的领英 (LinkedIn) 信息,她于 2018 年首次加入 OpenAI,并在这家初创公司的机器人团队工作,最终打造出一只可以解开魔方的机械手——据她的帖子称,这项任务耗时两年才完成。

随着 OpenAI 开始更加关注 GPT 范式,Weng 也开始关注。2021 年,这位研究人员转而帮助建立这家初创公司的应用人工智能研究团队。在 GPT-4 发布后,Weng 的任务是创建一个专门的团队,在 2023 年为这家初创公司构建安全系统。根据 Weng 的帖子,如今,OpenAI 的安全系统部门拥有 80 多名科学家、研究人员和政策专家。

人工智能安全专家的数量相当多,但许多人对 OpenAI 在试图构建越来越强大的人工智能系统时对安全的关注表示担忧。长期从事政策研究的 Miles Brundage于 10 月离开了这家初创公司,并宣布 OpenAI 将解散其 AGI 准备团队,而他曾为该团队提供过建议。

同一天,《纽约时报》报道了前 OpenAI 研究员Suchir Balaji,他说他离开 OpenAI 是因为他认为这家初创公司的技术给社会带来的危害大于好处。

OpenAI 向 TechCrunch 透露,其高管和安全研究人员正在努力寻找替代 Weng 的人选。

OpenAI 发言人在一封电子邮件声明中表示:我们非常感谢 Lilian 对突破性安全研究和建立严格技术保障的贡献。我们相信,安全系统团队将继续发挥关键作用,确保我们的系统安全可靠,为全球数亿人提供服务。

近几个月离开 OpenAI 的其他高管包括首席技术官 Mira Murati、首席研究官Bob McGrew 和研究副总裁 Barret Zoph。8月,著名研究员Andrej Karpathy和联合创始人John Schulman也宣布将离开这家初创公司。其中一些人,包括 Leike 和 Schulman,离开后加入了 OpenAI 的竞争对手 Anthropic,而其他人则继续创办自己的企业。