阿里巴巴的云计算部门刚刚发布了一款全新的 AI模型 ——Qwen2-VL。这款模型的强大之处在于它能够理解视觉内容,包括图片和视频,甚至可以实时分析长达20分钟的视频,可以说相当强悍。

与其他领先的先进模型(如 Meta 的 Llama3.1、OpenAI 的 GPT-4o、Anthropic的 Claude3Haiku 和 Google 的 Gemini-1.5Flash)相比,它在第三方基准测试中表现十分优秀。

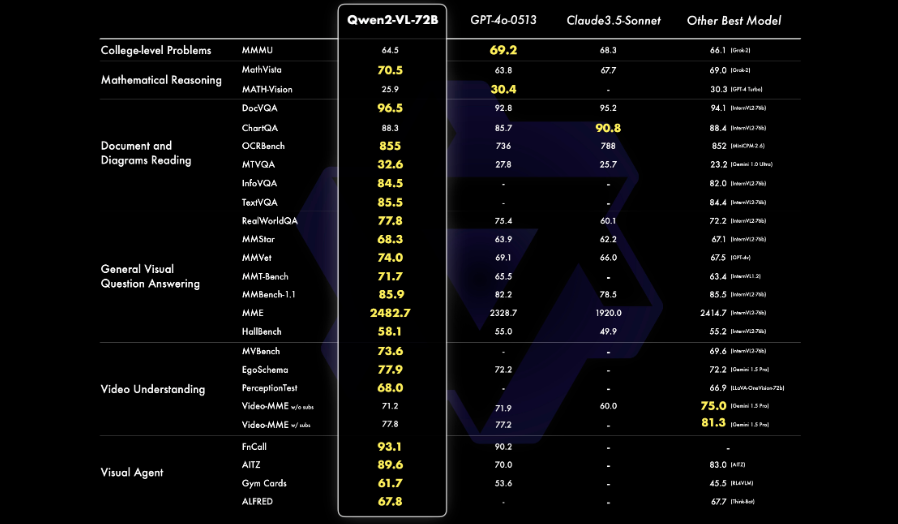

阿里从六个关键维度评估模型的视觉能力:复杂的大学水平问题解决、数学能力、文档和表格理解、多语言文本图像理解、一般场景问答、视频理解和基于代理的交互。其 72B 模型在大多数指标上都展示了顶级性能,甚至超过了 GPT-4o 和 Claude 3.5-Sonnet 等闭源模型。

具体如下图所示:

超强分析图像和视频能力

Qwen2-VL 不仅能够对静态图片进行分析,还能总结视频内容、回答与之相关的问题,甚至可以实时提供在线聊天支持。

正如 Qwen 研究团队在 GitHub 上关于新 Qwen2-VL 系列模型的博客文章中所写的那样:“除了静态图像之外,Qwen2-VL 还将其能力扩展到视频内容分析。它可以总结视频内容,回答与之相关的问题,并实时保持持续的对话流,提供实时聊天支持。此功能使其能够充当个人助理,通过提供直接从视频内容中提取的见解和信息来帮助用户。

官方称,可以分析超过20分钟的视频并回答有关内容的问题。这意味着,无论是在线学习、技术支持,还是任何需要对视频内容进行理解的场合,Qwen2-VL 都可以成为得力助手。

Qwen2-VL 的语言能力也相当强大,支持英语、中文以及多种欧洲语言,日语、韩语、阿拉伯语和越南语等多种语言,让全球用户都能轻松使用。为了让大家更好地理解它的能力,阿里巴巴还在他们的 GitHub 上分享了相关的应用示例。

三个版本

这款新模型有三个不同参数的版本,分别是 Qwen2-VL-72B(720亿参数)、Qwen2-VL-7B 和 Qwen2-VL-2B。其中,7B 和2B 版本在开源宽松的 Apache2.0许可证下提供,允许企业随意将它们用于商业目的。

最大的72B 版本目前还没有公开,只能通过专门的许可证和 API 获取。

Qwen2-VL 还引入了一些全新的技术特性,比如 Naive Dynamic Resolution 支持,可以处理不同分辨率的图像,确保视觉解读的一致性和准确性。还有 Multimodal Rotary Position Embedding(M-ROPE)系统,能够在文本、图像和视频之间同步捕捉和整合位置信息。

附模型链接如下:

-

Qwen2-VL-2B-Instruct:https://www.modelscope.cn/models/qwen/Qwen2-VL-2B-Instruct

-

Qwen2-VL-7B-Instruct:https://www.modelscope.cn/models/qwen/Qwen2-VL-7B-Instruct