之前和大家分享过一些体验Flux模型的方式。

Flux【基础篇】:分享一些可以在线体验Flux.1模型的网站

Flux【基础篇】:ComfyUI Flux.1工作流的本地部署安装教程

今天我们来分享一下如何在本地部署ComfyUI Flux.1 dev GGUF工作流。

一. 初识GGUF

GGUF全称为GPT-Generated Unified Format,一种专为大型语言模型设计的二进制文件格式,由llama.cpp创始人Georgi Gerganov提出,用于高效存储和交换大模型的预训练结果。这种格式优化了数据结构和编码方式,显著提升了模型文件的存储效率,并保证了快速的加载性能。

在Github上XLabs-AI官方网站,对于低内存的使用也是首推GGUF。

- https://github.com/XLabs-AI/x-flux-comfyui

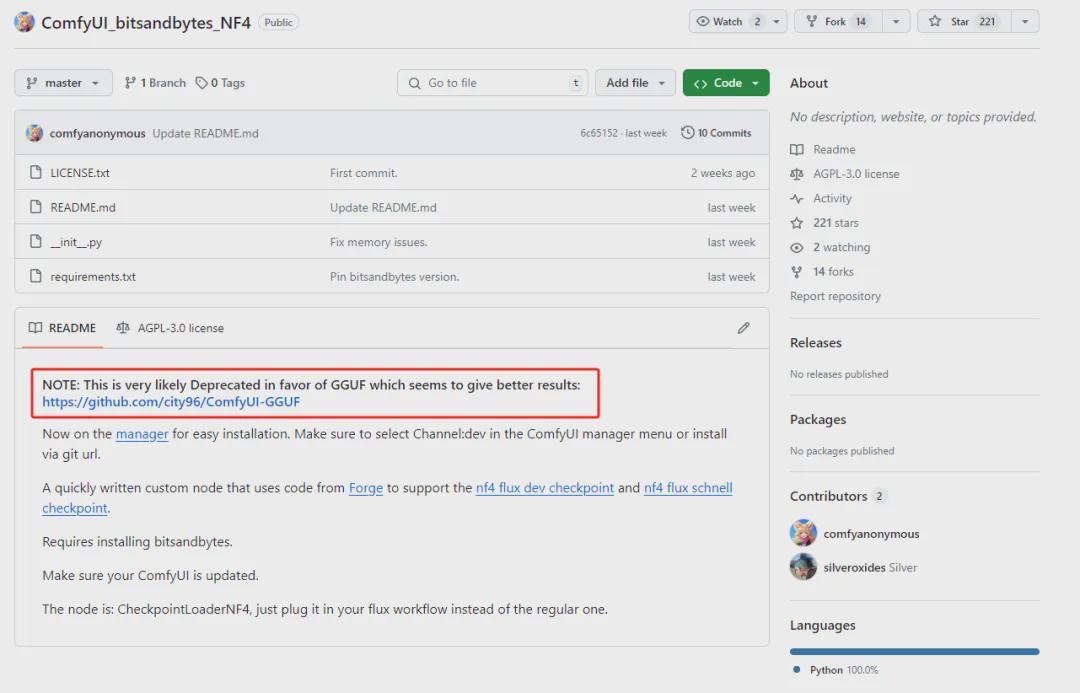

另外,很多小伙伴也听过或者使用过另一种低显存的使用方式:Flux.1 dev NF4,目前这种方式已被废弃。

- https://github.com/comfyanonymous/ComfyUI_bitsandbytes_NF4

二. Flux.1 dev GGUF工作流搭建

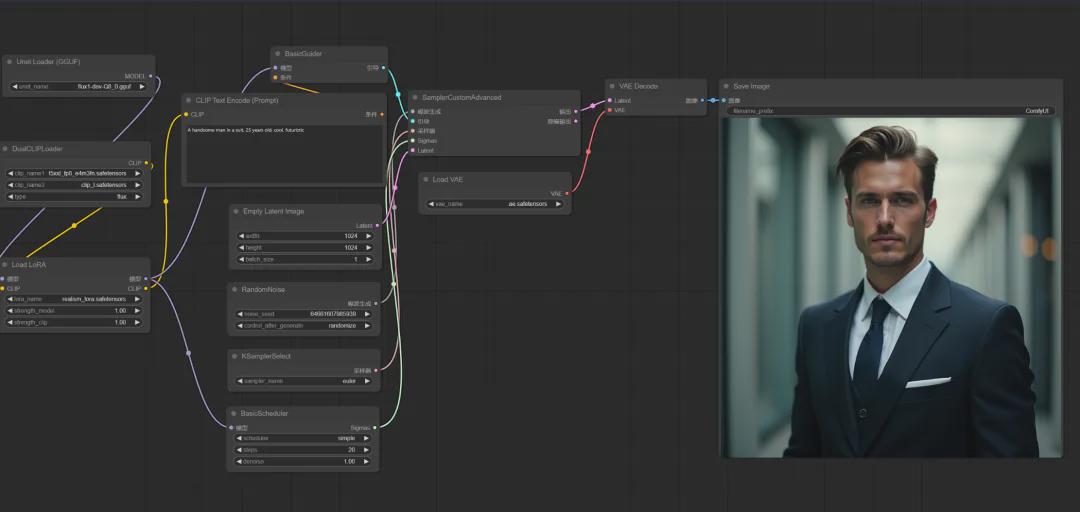

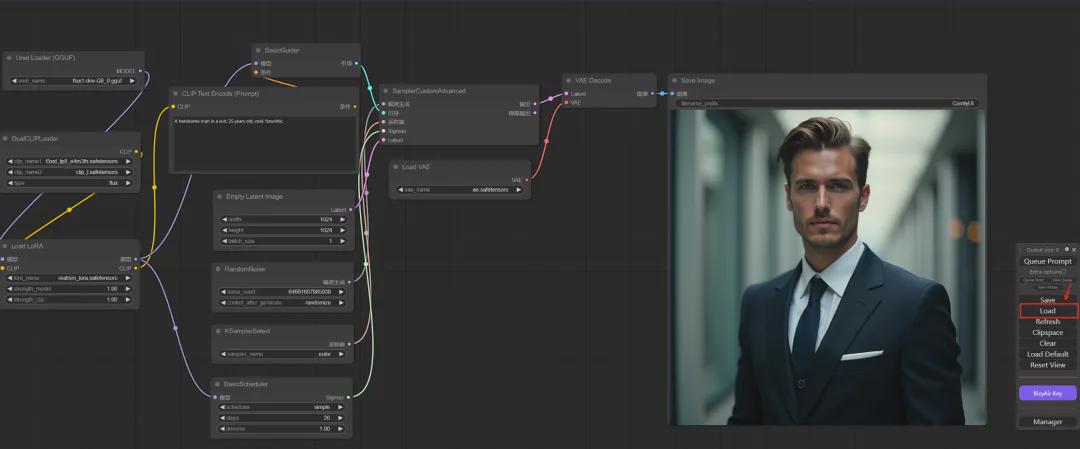

我们以下面一个比较典型的ComfyUI Flux.1 dev GGUF工作流为例来进行详细说明(工作流文末网盘地址可以获取)。

相关说明:如果ComfyUI不是最新版本,需要先将ComfyUI更新到最新版本。

1. 插件的安装

- 插件地址:https://github.com/city96/ComfyUI-GGUF

通过插件管理器搜索ComfyUI-GGUF。

直接点击install按钮就可以完成安装。

也可以在\ComfyUI\custom_nodes目录下使用git命令安装到本地。

- git clone https://github.com/city96/ComfyUI-GGUF

安装完成后重启一下ComfyUI。

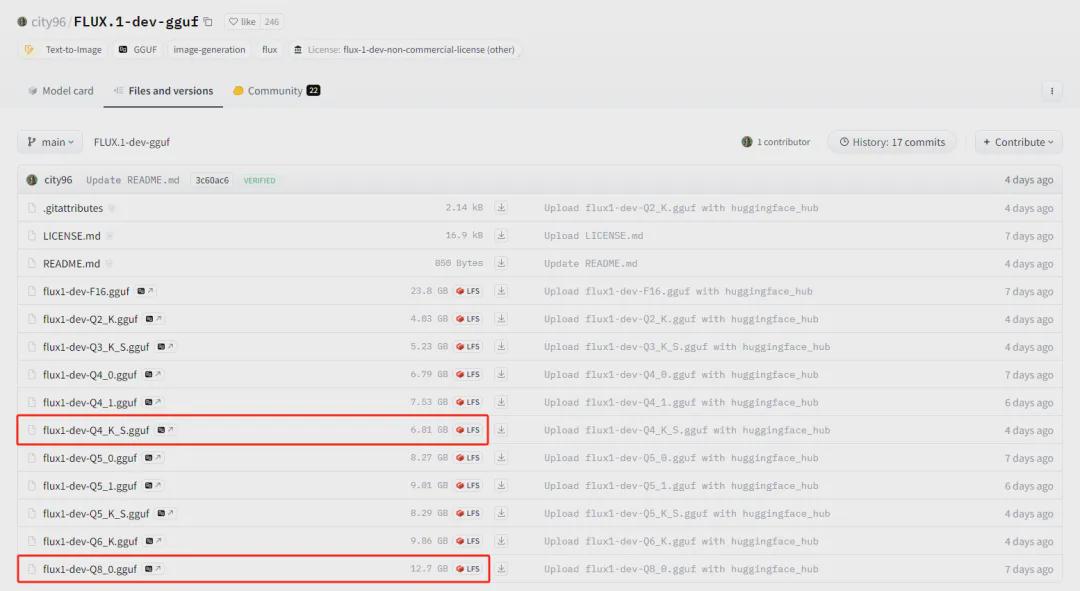

2. flux1-dev GGUF模型的下载(文末网盘地址也可获取)

- https://huggingface.co/city96/FLUX.1-dev-gguf/tree/main

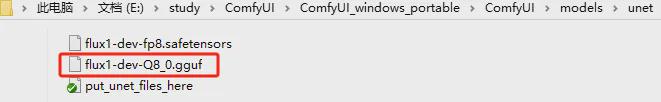

将下载的大模型放置到ComfyUI\models\unet目录下。

- 对于dev版本推荐:flux1-dev-Q8_0.gguf

- 对于channel版本推荐:flux1-dev-Q4_K_S.gguf

3. CLIP模型的下载

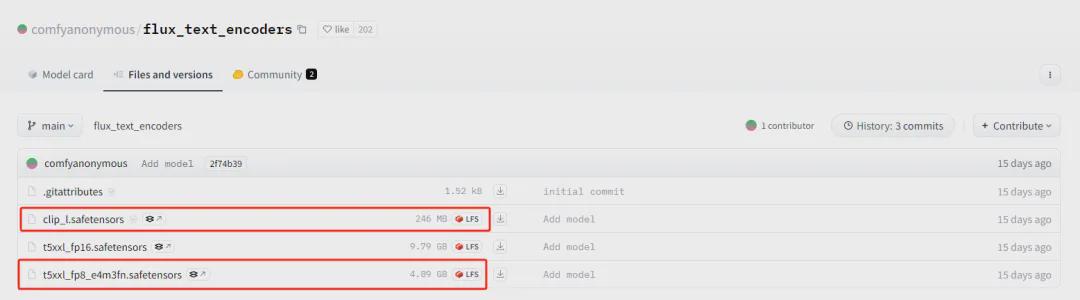

- https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main

下载t5xxl_fp8_e4m3fn.safetensors(4.89 GB)和clip_l.safetensors(246 MB)文件放置到\ComfyUI\models\clip目录下。

4. VAE模型的下载

- https://huggingface.co/black-forest-labs/FLUX.1-dev/tree/main

下载ae.safetensors(335M)文件放置到\ComfyUI\models\vae目录下。

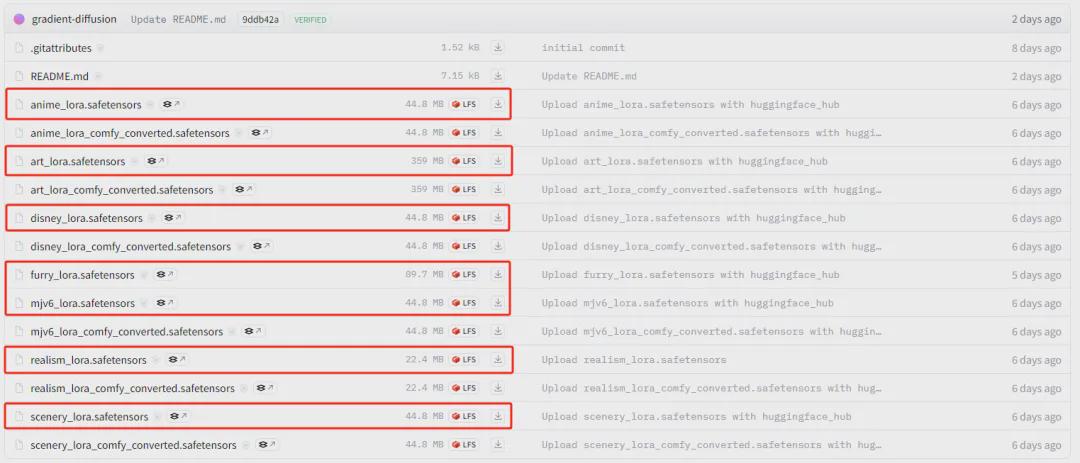

5. LORA模型的下载

- https://huggingface.co/XLabs-AI/flux-lora-collection/tree/main

目前Flux.1发布了7款loar,分别是动漫,艺术、迪士尼、MJV6、毛绒、写实、风景。下载所需要的loar模型文件放置到ComfyUI\models\loras目录下。

6. 使用工作流

点击ComfyUI启动脚本文件, 在主界面点击"load" 按钮,把工作流文件加载进来。

至此,Flux.1 dev GGUF的ComfyUI工作流就可以应用了。

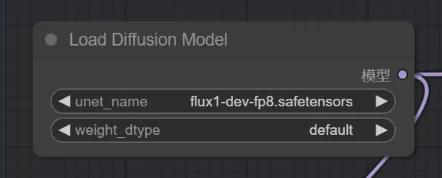

相关说明:Flux.1 dev和Flux.1 dev GGUF工作流的主要区别。

Flux.1 dev工作流中使用Load Diffusion Model节点

Flux.1 dev GGUF工作流使用Unet Loader (GGUF) 节点

好了,今天的分享就到这里了,希望今天分享的内容对大家有所帮助。

模型和工作流放在网盘里,感兴趣的小伙伴自取!

https://pan.quark.cn/s/b3df771404e2