微软宣布发布三款全新的 Phi-3.5模型,进一步巩固了其在多语言和多模态人工智能发展的领先地位。这三款新模型分别是:Phi-3.5-mini-instruct、-3.5-MoE-instruct 以及 Phi-3.5-vision-instruct,各自针对不同的应用场景。

Phi-3.5Mini Instruct 模型是一个轻量级的 AI模型,参数数量为3.8亿,非常适合计算能力有限的环境。它支持128k 的上下文长度,专门优化了指令执行能力,适合代码生成、数学问题求解和逻辑推理等任务。尽管体积不大,这款模型在多语言和多轮对话任务中表现出了令人瞩目的竞争力,超越了同类的其他模型。

入口:https://huggingface.co/microsoft/Phi-3.5-mini-instruct

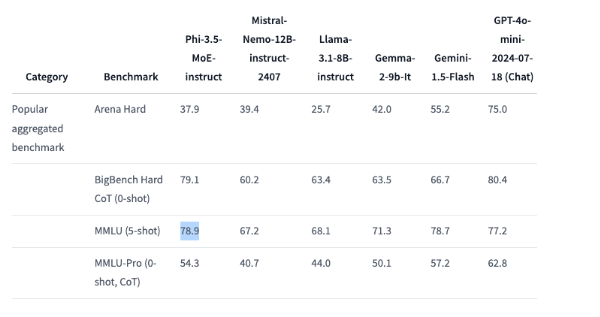

Phi-3.5MoE 模型,这是一款 “专家混合” 模型,结合了多种不同类型的模型,每个都专注于特定任务。它拥有419亿的参数,支持128k 的上下文长度,可以在多种推理任务中展现强大的性能。这款模型在代码、数学和多语言理解方面的表现都非常出色,甚至在一些基准测试中超过了更大型的模型,比如在 MMLU(大规模多任务语言理解)上超越了 OpenAI 的 GPT-4o mini。

入口:https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

Phi-3.5Vision Instruct 模型是一款先进的多模态 AI 模型,集成了文本和图像处理能力,适合图像理解、光学字符识别、图表和表格分析以及视频总结等任务。这款模型同样支持128k 的上下文长度,能够处理复杂的多帧视觉任务。

入口:https://huggingface.co/microsoft/Phi-3.5-vision-instruct

为了训练这三款模型,微软进行了大规模的数据处理。Mini Instruct 模型使用了3.4万亿个标记,在512个 H100-80G GPU 上训练了10天;Vision Instruct 模型则用了5000亿个标记,经过6天的训练;而 MoE 模型则是在23天内使用了4.9万亿个标记进行训练。

值得一提的是,这三款 Phi-3.5模型均采用 MIT 开源许可证发布,开发者可以自由使用、修改和分发这些软件。这不仅体现了微软对开源社区的支持,也让更多的开发者能够在自己的应用中集成尖端的 AI 能力。