最近,Zyphra 公司发布了全新的 Zamba2-2.7B 语言模型,这一发布在小型语言模型的发展史上具有重要意义。新模型在性能和效率方面取得了显著提升,它的训练数据集达到了大约3万亿个标记,这使得它在性能上可以与 Zamba1-7B 及其他领先的7B 模型相媲美。

而最令人惊喜的是,Zamba2-2.7B 在推理时的资源需求显著降低,成为了移动设备应用的高效解决方案。

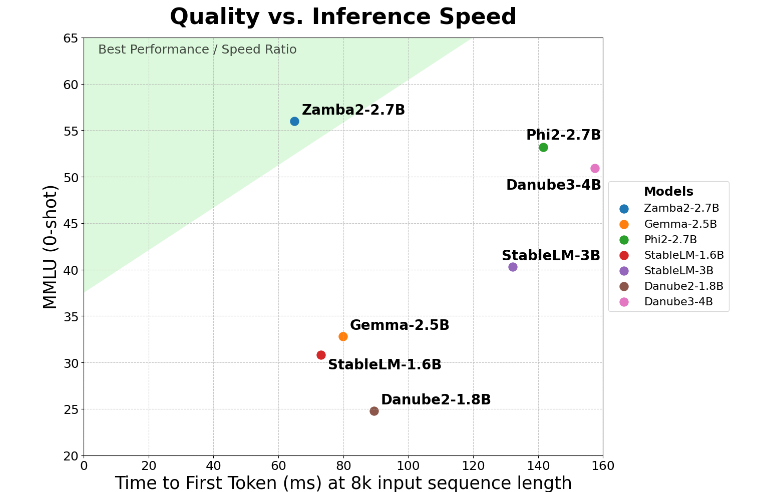

Zamba2-2.7B 在 “首次生成响应时间” 这一关键指标上实现了两倍的提升,这意味着它可以比竞争对手更快地生成初始响应。这对于虚拟助手、聊天机器人等需要实时互动的应用来说至关重要。

除了速度的提升,Zamba2-2.7B 在内存使用上也做得非常出色。它减少了27% 的内存开销,使得它成为在内存资源有限的设备上部署的理想选择。这样的智能内存管理确保了模型在计算资源受限的环境中也能有效运行,扩展了其在各种设备和平台上的应用范围。

Zamba2-2.7B 还有一个显著的优势,那就是生成延迟更低。与 Phi3-3.8B 相比,它的延迟降低了1.29倍,这使得交互更加流畅。低延迟在需要无缝、持续交流的应用中尤为重要,比如客服机器人和互动教育工具。因此,Zamba2-2.7B 在提升用户体验方面无疑是开发者的首选。

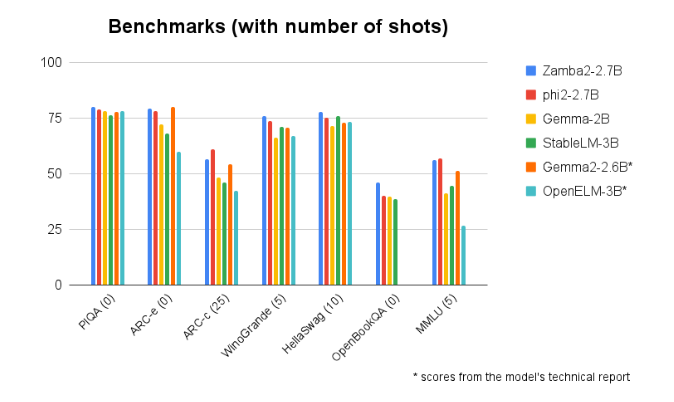

在与其他同类规模模型的基准比较中,Zamba2-2.7B 始终表现优异。它的优越表现证明了 Zyphra 在推动人工智能技术发展上的创新和努力。这一模型采用了改进的交错共享注意力机制,并配备了 LoRA 投影器在共享的 MLP 模块上,确保了在处理复杂任务时的高效能输出。

模型入口:https://huggingface.co/Zyphra/Zamba2-2.7B