最近,苹果公司的人工智能团队和华盛顿大学等多家机构合作,推出一款名叫 DCLM的开源语言模型。这款模型的参数达7亿,并且在训练过程中使用了多达2.5万亿个数据令牌,帮助我们更好地理解和生成语言。

那么,什么是语言模型呢?简单来说,它是一种可以分析和生成语言的程序,能够帮助我们完成各种任务,比如翻译、文本生成和情感分析。为了让这些模型表现得更好,我们需要优质的数据集。然而,获取和整理这些数据并不是一件容易的事,因为我们需要过滤掉无关的或有害的内容,并去除重复的信息。

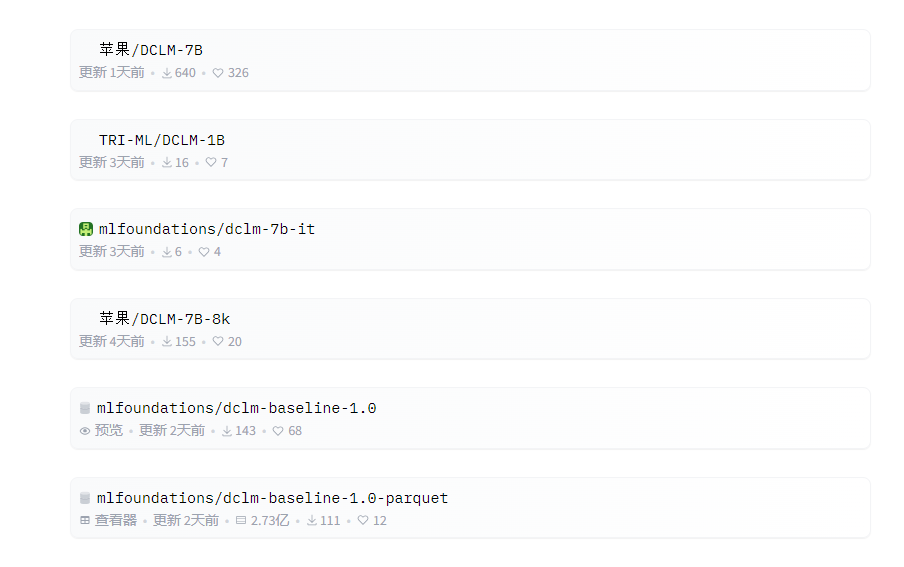

为了应对这个挑战,苹果的研究团队推出了 “数据集竞争”(DataComp for Language Models,简称 DCLM),这是一种用于语言模型的数据集优化工具。他们最近在 Hugging Face 平台上开源了 DCIM 模型和数据集。开源版本包括DCLM-7B、DCLM-1B、dclm-7b-it、DCLM-7B-8k、dclm-baseline-1.0和dclm -baseline-1.0-parquet,,研究人员可以通过这个平台进行大量实验,找到最有效的数据整理策略。

https://huggingface.co/collections/mlfoundations/dclm-669938432ef5162d0d0bc14b

DCLM 的核心优势在于它的结构化工作流程。研究人员可以根据需要选择不同规模的模型,从4.12亿到7亿参数不等,同时还可以试验不同的数据整理方法,比如去重和过滤。通过这些系统化的实验,研究人员可以清晰地评估不同数据集的质量。这不仅为未来的研究奠定了基础,也帮助我们理解如何通过改善数据集来提升模型的表现。

例如,利用 DCLM 建立的基准数据集,研究团队训练了一个7亿参数的语言模型,竟然在 MMLU 基准测试中取得了64% 的5-shot 准确率!这相较于之前的最高水平提高了6.6个百分点,并且使用的计算资源减少了40%。DCLM 基线模型的表现也与 Mistral-7B-v0.3和 Llama38B 相当,而后两者需要的计算资源要多得多。

DCLM 的推出为语言模型的研究提供了一个新的标杆,帮助科学家们系统化地提升模型的性能,同时降低了所需的计算资源。