等待的时候先看看这篇文章吧,快手可灵开源了LivePortrait!

本篇内容手把手教你如何使用LivePortrait,无需本地搭建,而且免费!

长文预警🚨🚨

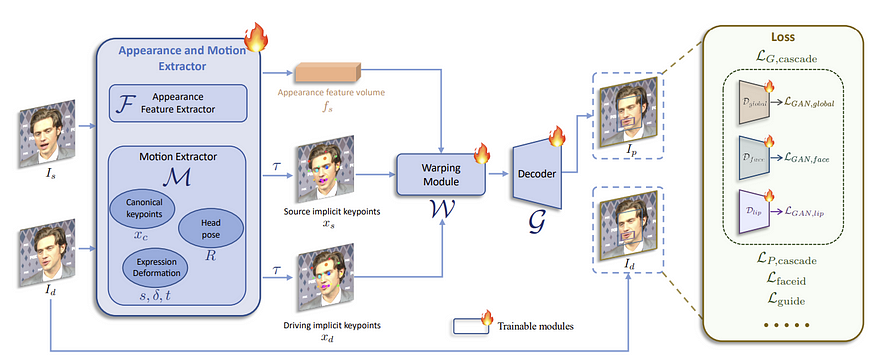

先了解一下LivePortrait

LivePortrait简单来说就是“表情迁移”,即提供一张图片、一个参考视频,通过LivePortrait的AI运算,就可以把参考视频的表情动作原封不动的复刻到图片上。

图片来自 LivePortrait 白皮书

在这里就不过多赘述复杂的理论知识了,毕竟《冲破信息差》一直以来都是以“实战”、“实用”、“干货”为主要运营理念。

接下来,我将介绍两种线上使用LivePortrait的方法,大家可以根据自己的需求来选择。

方法一

Huggingface

Huggingface自从AI爆发以来,一直都是开源社区的头部产品。大家应该都有所了解,在这也不做过多的介绍了。

Huggingface在线体验链接:

https://huggingface.co/spaces/KwaiVGI/LivePortrait

选择Huggingface的优点:

- 界面一目了然

- 操作简单

- 运行速度快,无需等待太久即可获得结果

- 有图片编辑功能

Huggingface的缺点:

- 作为线上试用体验,不能生成长视频。目前我试用下来,最多只能生成≤9秒的视频。

- 视频无声音

但是作为尝鲜体验已经足够了!

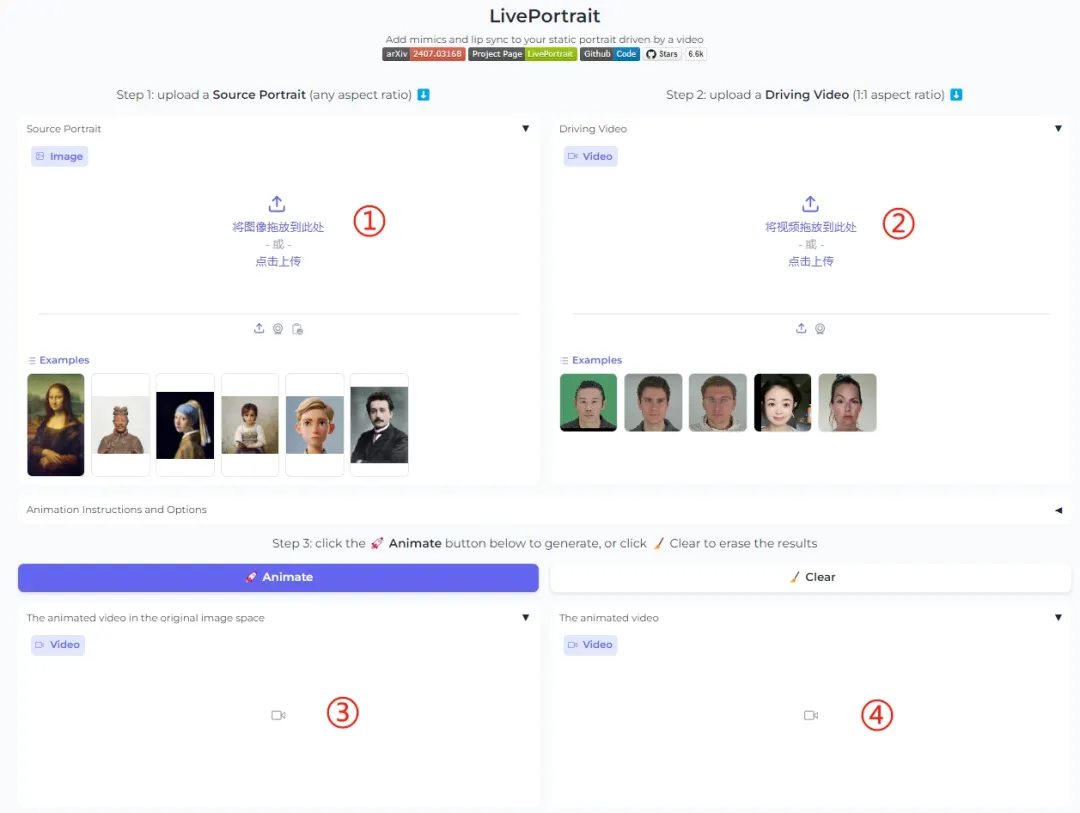

Huggingface LivePortrait教学

Huggingface LivePortrait 界面

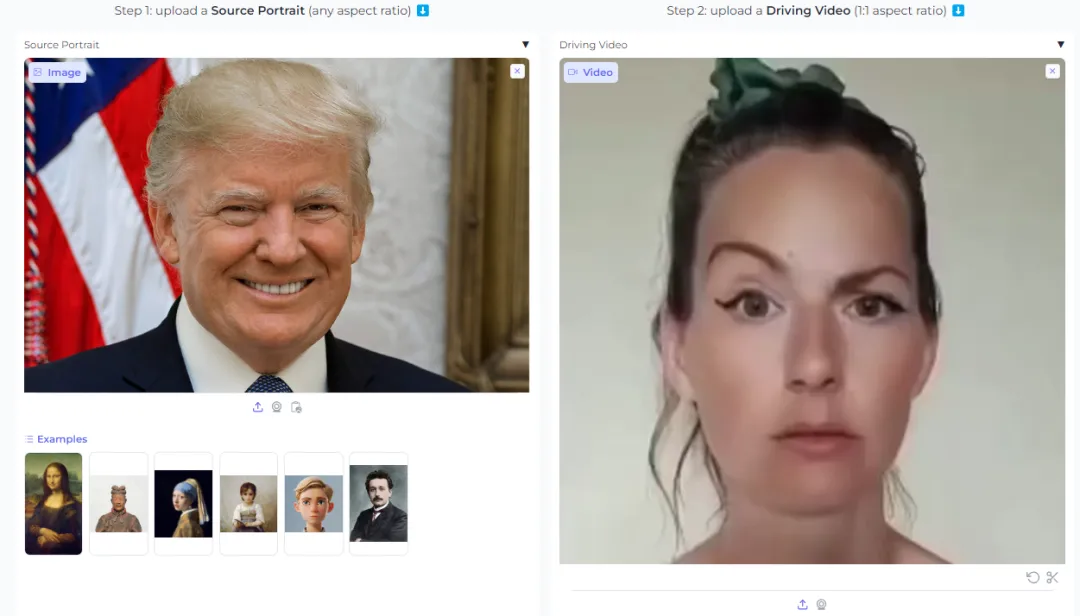

- 在 ① 处,上传你想要制作的图片,不限图片比例,1:1、16:9、3:4等等都可以!LivePortrait只识别、编辑面部。

- 在 ② 处,上传你想要的面部动作视频,这个问题在于,因为我前面说的Huggingface的LivePortrait只能制作最多9秒的视频,所以如果你的参考视频比较长,那你可能要取舍一下,截取出9秒的视频,并上传。

上传好①和②后,就可以点击【🚀Animate】按钮,等待制作

在 ③ 处,你会看到已经制作好的单一图片视频

在 ④ 处,官方很贴心的已经帮你制作好了对比视频

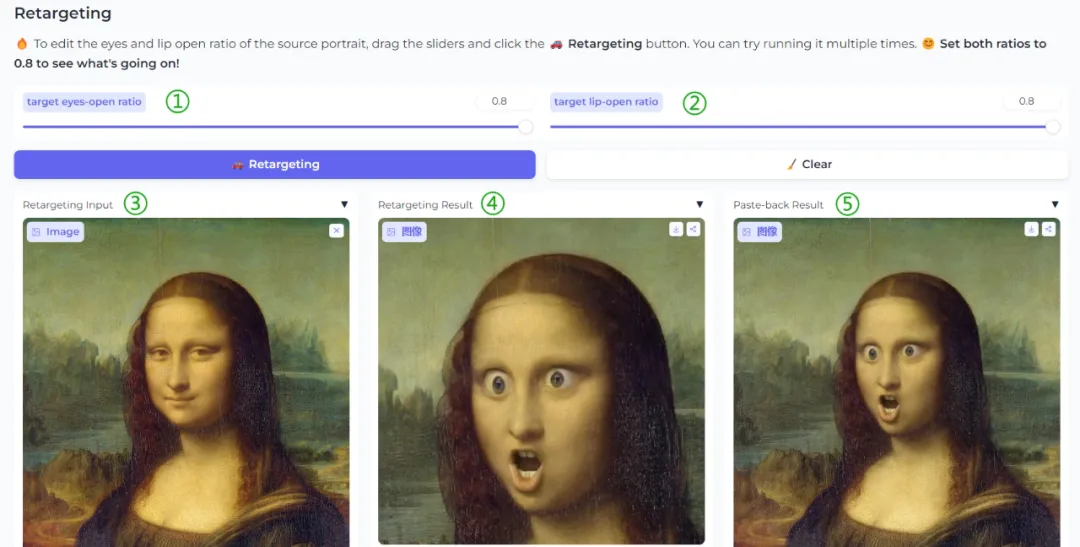

鼠标下滑,会发现还有一个模块Retargeting

Retargeting是单独编辑图片面部表情的工具

在 ① 处,可以调节眼睛的睁开幅度,比例为0-0.8,0.8拉满就是眼睛睁到最大,0就是闭眼

在 ② 处,可以调节嘴巴的张开幅度,同理,比例为0-0.8

在 ③ 处,上传想要调整的图片,也是不限图片比例

在 ④ 处,可以得到单独面部的处理结果

在 ⑤ 处,可得到图片处理后的整体效果

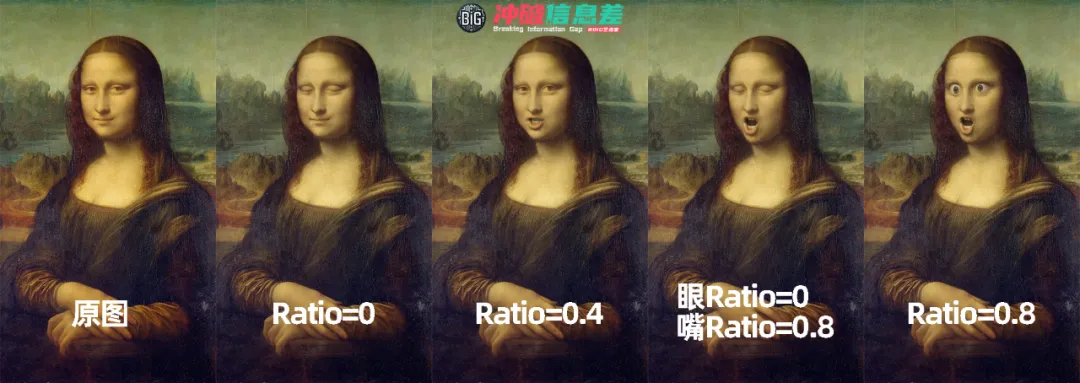

大家可以看一下不同Ratio下的对比,参数对于眼睛和嘴的调整还是很明显的,可玩性很高。

方法二

Google Colab

这个海外的一位大神,直接将Github上的代码做进了Google Colab里,也是线上操作。

我从没用过Google Colab,在查询无果后,我去Reddit上和大神进行了亲密交谈(厚着脸皮求教),学会了如何在这个Colab上使用LivePortrait

Google Colab在线体验链接:

https://t.co/Kn10Aqxm7R

选择Google Colab的优点:

- 可制作与参考视频同等时长的视频

- 生成的视频直接引用参考视频音频

Google Colab的缺点:

- 操作起来稍复杂

- 免费版可能会受到Google GPU的限制(受限的话第二天再来做就行)

Google Colab LivePortrait教学

使用Google Colab前需要准备一个Google账号

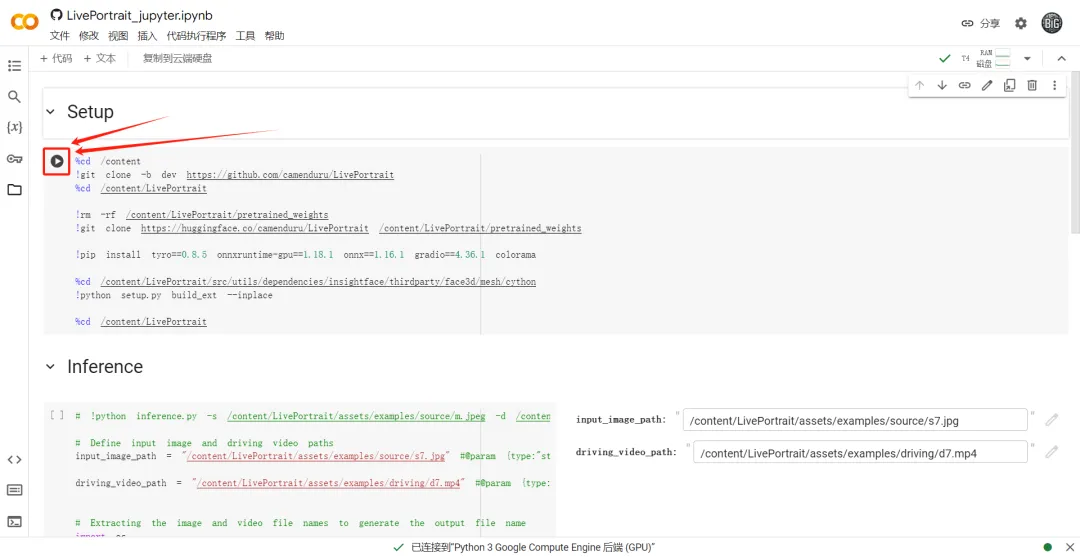

一、Setup

刚进入Colab页面不用怕,其实一点也不复杂

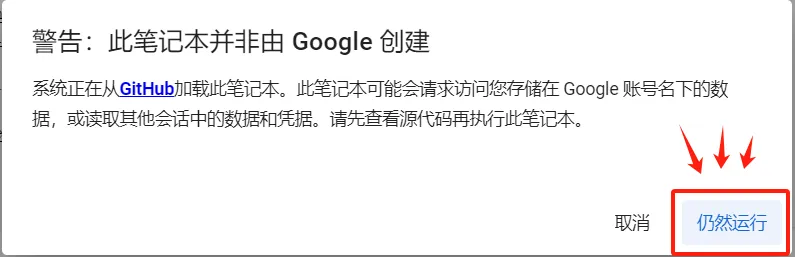

直接点击上图红框标出的【运行按钮】,然后会出现下图提示

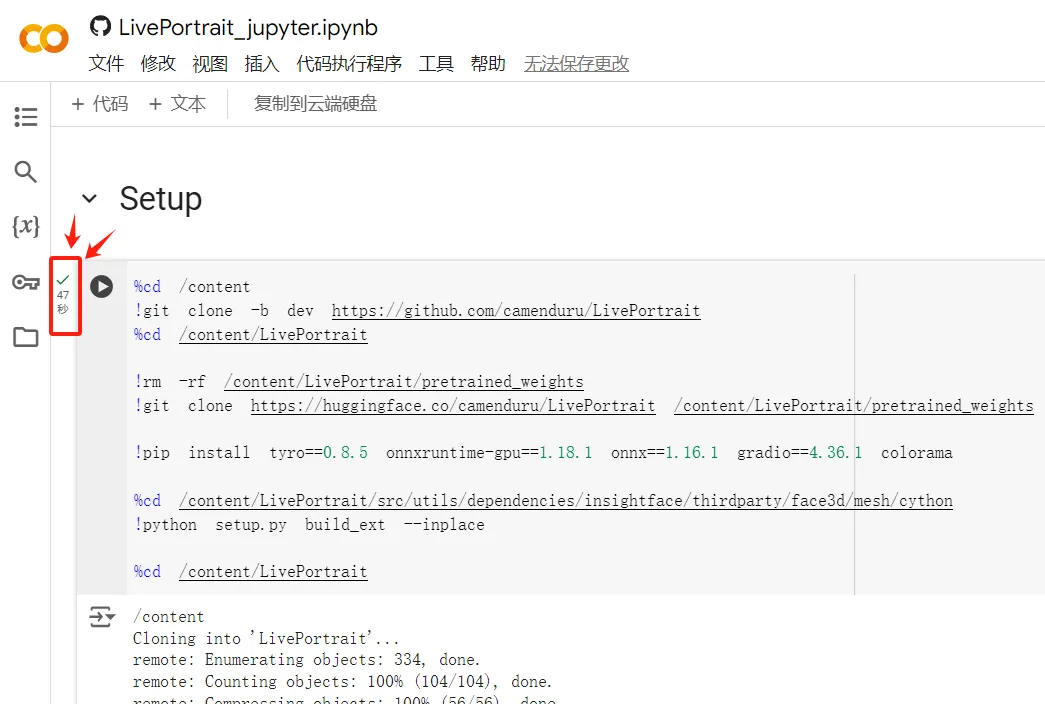

点击【仍然运行】,Colab就会自动运行代码了,出现什么你都不用管,也不用动,等他运行完会显示的,如下图所示

显示 “47秒” 完成,只要你网速正常,一般1分钟之内第一步Setup就完成了。

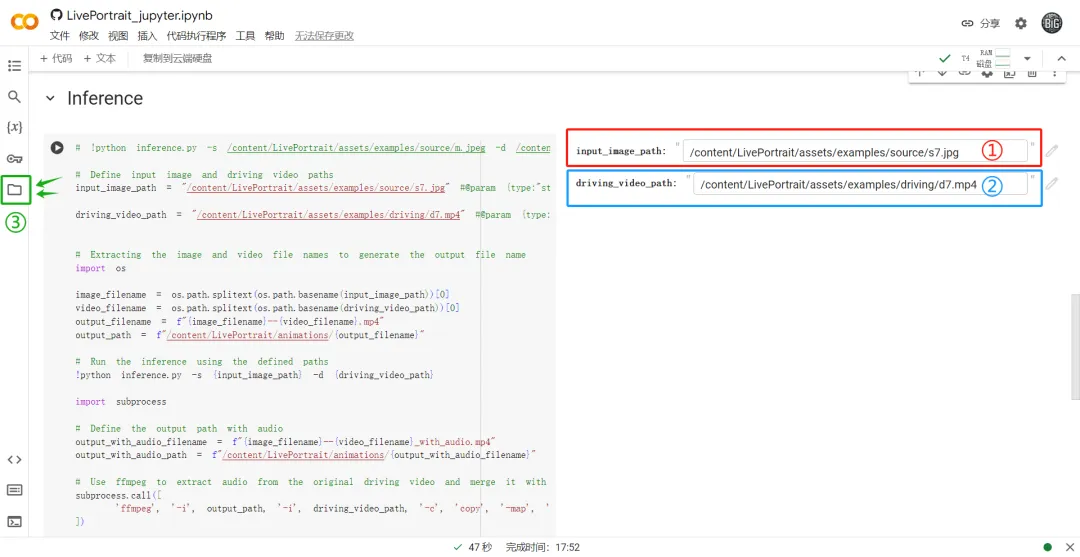

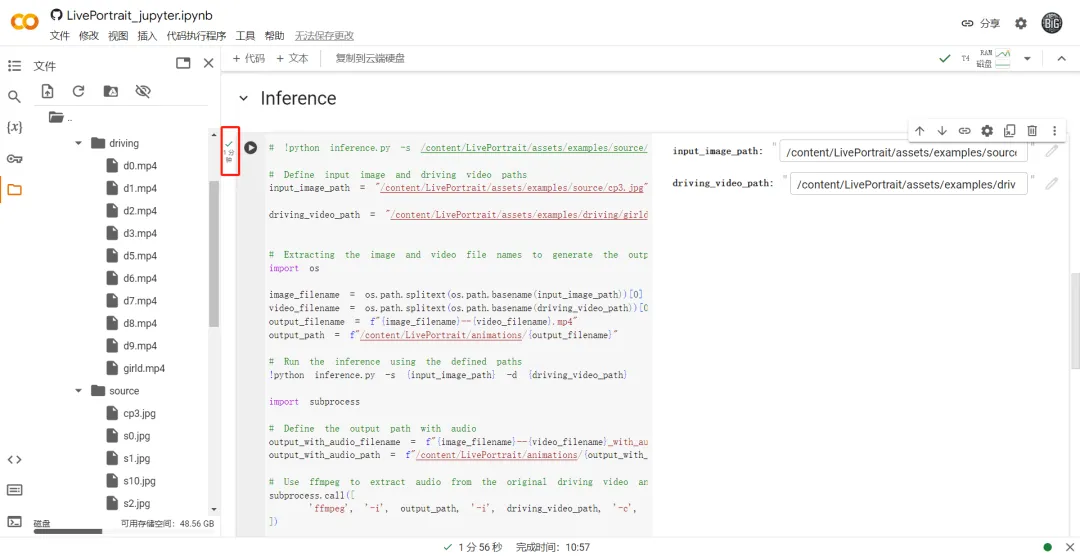

二、Inference

第二步是如何上传图片和视频,是最复杂的地方(其实不复杂的,耐心看)

我们使用Colab时,因为是线上运行,所以需要把图片、视频上传到Colab内。先整体看一下操作界面:

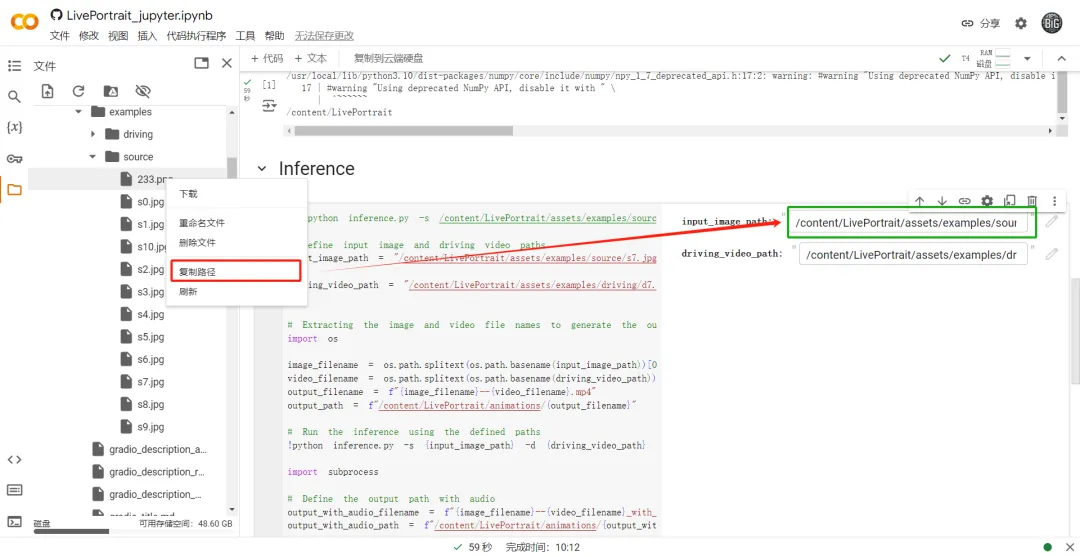

在 ① 处,粘贴图片路径

在 ② 处,粘贴参考动作视频的路径

在 ③ 处,上传文件,图片视频都可上传,且不限比例

那么文件应该怎么传呢?上传到哪里呢?请看下图👇

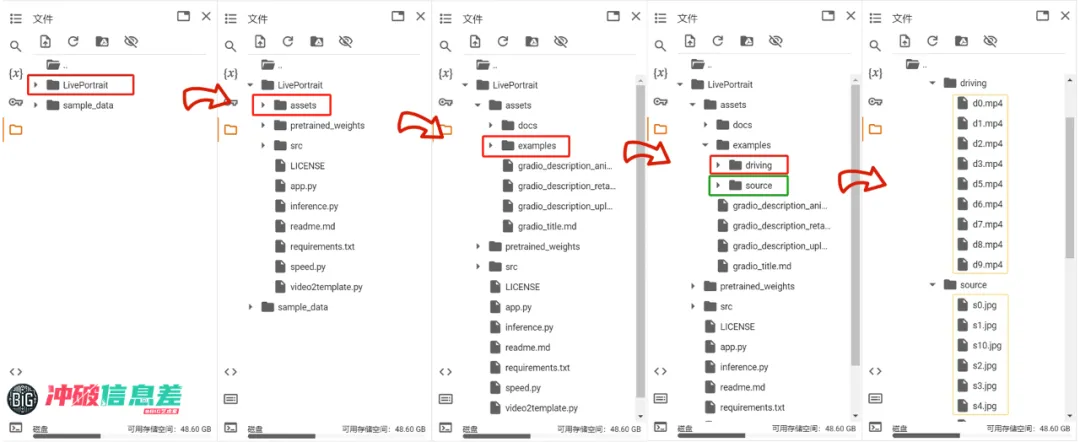

点击【文件夹】后,按照以下路径寻找

content--LivePortrait--assets--examples

就会看到两个文件夹【driving】和【source】

【driving】文件夹,用来放置视频

【source】文件夹,用来放置图片

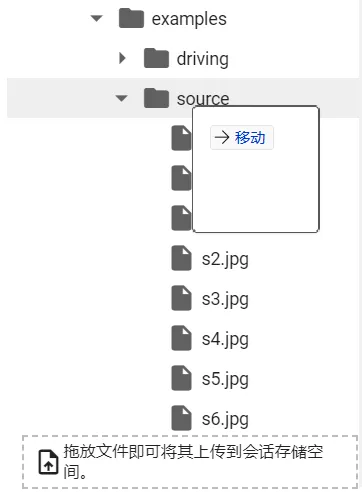

直接拖放就可以上传文件了,也是很方便的

上传好视频/图片后,我们需要复制素材的路径

直接选择素材,然后右键,点击【复制路径】,把素材路径粘贴到对应的框中即可。

大神已经在这两个文件夹里放了很多官方Github中提供的素材,大家可以直接玩。

放好素材路径后,点击Inference对应的【运行按钮】,等待AI运算。

Inference这一步的运行时长是根据你所提供的视频长度来计算的,参考视频时间越长,运行的时间越长。

上图的参考视频时长是11秒,运行时长1分钟,还是可以接受的。

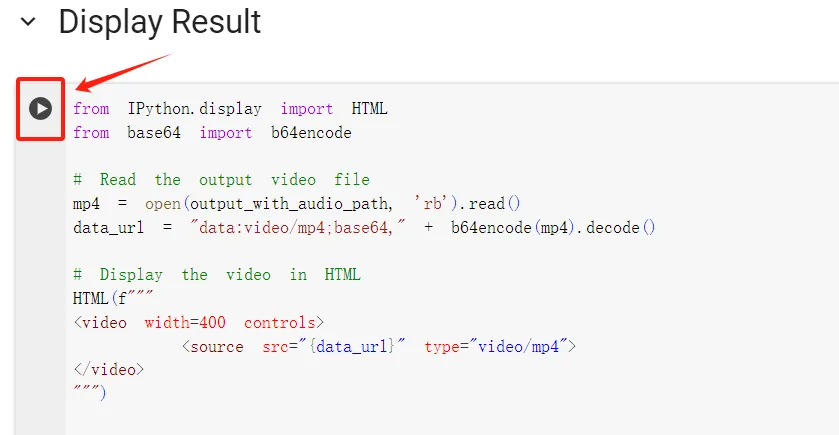

三、Display Result

第二步运行结束后,是不会有视频出来的,还需要点击第三步Display Result的【运行按钮】

我测试下来,一般30秒的参考视频,运行时长在2~4分钟左右,当时的云端GPU使用情况和自己的网速情况也会对运行时长有所影响。

我在Colab里选择了同一个参考视频(30秒),Colab可以完整生成30秒(带背景音),而Huggingface只能最多生成9秒(无背景音)。

关于上面提到的缺点 “免费版可能会受到Google GPU的限制”,我个人试玩一周多的时间,只遇到了一次GPU限制,所以大家也不用太担心,Colab的稳定性还是很强的。

重点提示

目前线上的LivePortrait仅支持人脸,也就是如果你上传了一张拟人动物的肖像图,是会报错的。

如果你想自己在本地部署LivePortrait的话,可以前往官方Github主页

官方Github主页链接:

https://github.com/KwaiVGI/LivePortrait

以上就是可以让你不用等可灵审核,就能用上可灵AI视频功能LivePortrait的两个方法。我的建议是两个可以结合起来使用(反正都是免费的)