智谱AI 宣布,训练了一种新的视频理解模型 CogVLM2-Video,并将其开源。

据介绍,当前大多数的视频理解模型使用帧平均和视频标记压缩方法,导致时间信息的丢失,无法准确回答与时间相关的问题。一些专注于时间问答数据集的模型过于局限于特定格式和适用领域,使得模型失去了更广泛的问答能力。

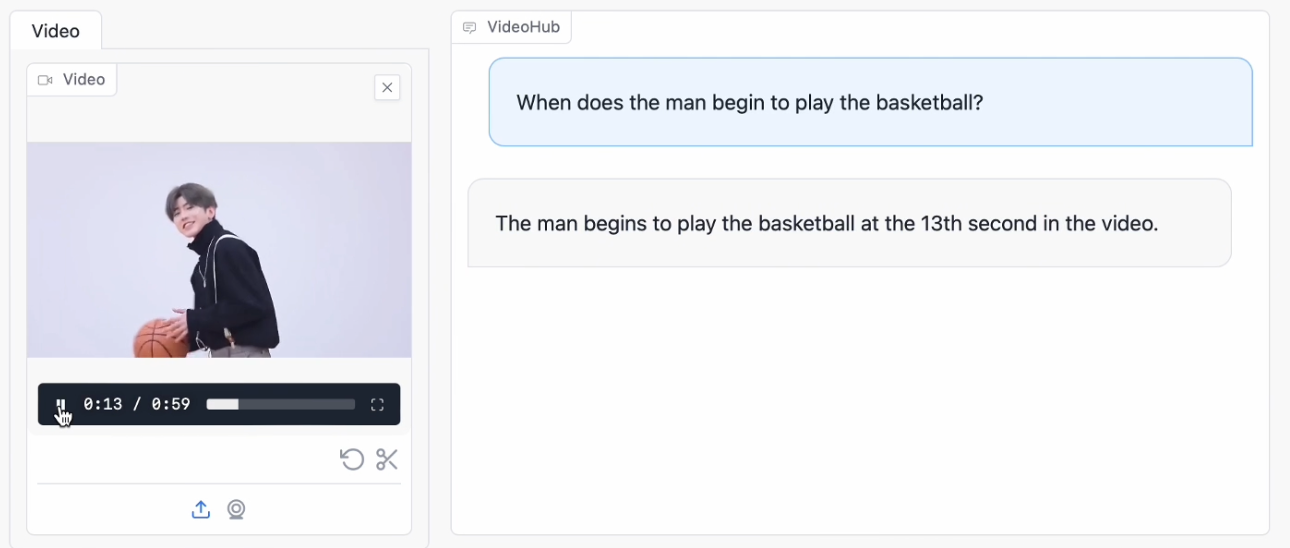

▲ 官方效果演示

智谱 AI 提出了一种基于视觉模型的自动时间定位数据构建方法,生成了 3 万条与时间相关的视频问答数据。基于这个新数据集和现有的开放领域问答数据,引入了多帧视频图像和时间戳作为编码器输入,训练出 CogVLM2-Video 模型。

智谱 AI 表示,CogVLM2-Video 不仅在公共视频理解基准上达到了最新的性能,还在视频字幕生成和时间定位方面表现出色。

附相关链接: