谷歌 DeepMind 首次进行了关于最常见的恶意 AI应用的研究,结果显示生成虚假政治家和名人的人工智能(AI)“Deepfakes” 比用 AI 协助网络攻击的尝试更为普遍。这一研究是谷歌 AI 部门 DeepMind 和谷歌旗下的研发单位 Jigsaw 合作的,目的是量化生成 AI 工具的风险,这些工具已被全球最大的科技公司推向市场以寻求巨额利润。

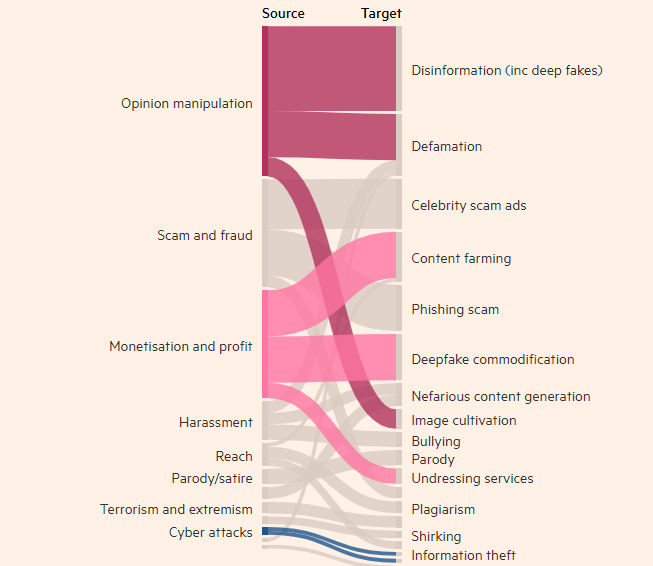

与技术相关的不良行为者的动机

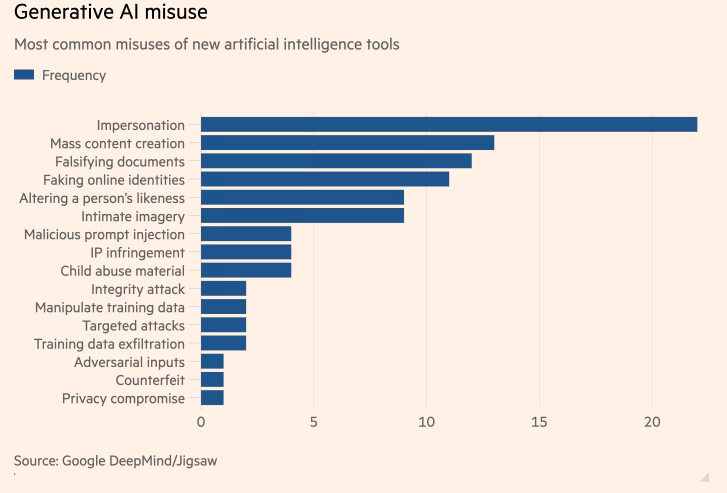

研究发现,制作真实但虚假的人物图像、视频和音频的行为几乎是滥用生成 AI 工具的次数最多的一种,比其他次高的使用文本工具(例如聊天机器人)伪造信息的方式高出近两倍。滥用生成 AI 的最常见目标是影响公众舆论,这占用了27% 的使用情况,引发了对 Deepfakes 如何影响今年全球选举的担忧。

近几个月来,英国首相 Rishi Sunak 和其他全球领袖的 Deepfakes 出现在 TikTok、X 和 Instagram 上。英国选民将在下周的大选中投票。尽管社交媒体平台努力标注或删除此类内容,但人们可能不会认识到这是虚假的,而内容的传播可能会影响选民的投票。DeepMind 的研究人员分析了大约200起滥用行为,涉及社交媒体平台 X 和 Reddit,以及在线博客和媒体报道滥用行为的情况。

研究发现,滥用 AI 生成产品(如 OpenAI 的 ChatGPT 和谷歌的 Gemini)的第二大动机是赚钱,无论是提供创建 Deepfakes 的服务,还是使用生成 AI 创建大量内容,例如虚假新闻文章。研究发现,大多数滥用行为使用易于获得的工具,“需要最少的技术专业知识”,这意味着更多的不良行为者可以滥用生成 AI。

DeepMind 的研究将影响其改进评估模型的安全性,并希望这也会影响其竞争对手和其他利益相关者如何看待 “危害的表现”。