官网:https://ollama.com/

Github:https://github.com/ollama/ollama

Ollama 是一个开源平台,用于管理和运行各种大型语言模型 (LLM),例如 Llama3、gemma 和 qwen。

它提供命令行界面 (CLI) 用于安装、模型管理和交互。

您可以使用 Ollama 根据您的需求下载、加载和运行不同的 LLM 模型。

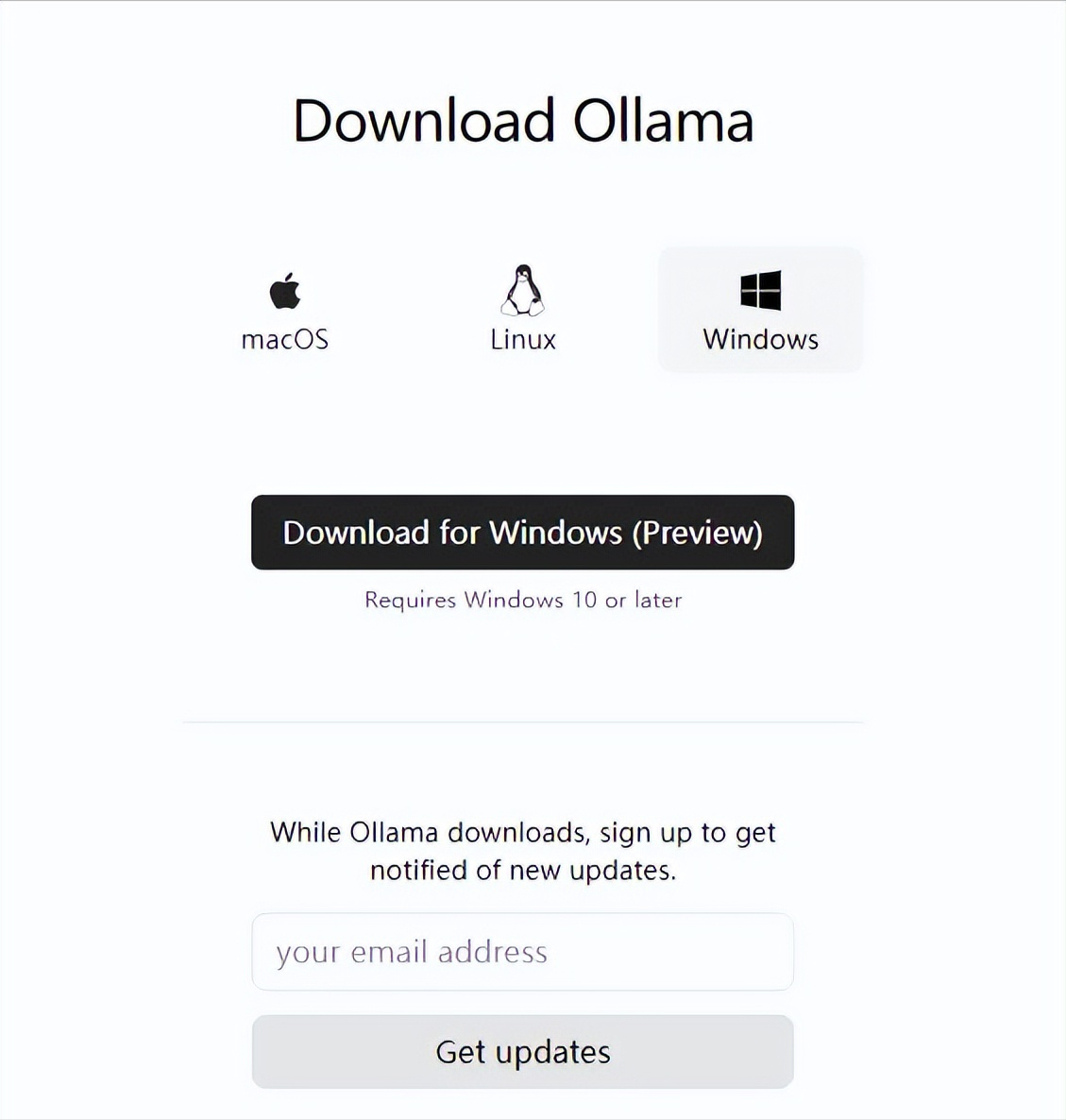

#Windows安装

要求:win10以上操作系统

安装包下载地址:https://ollama.com/download/windows

下载对应系统安装包

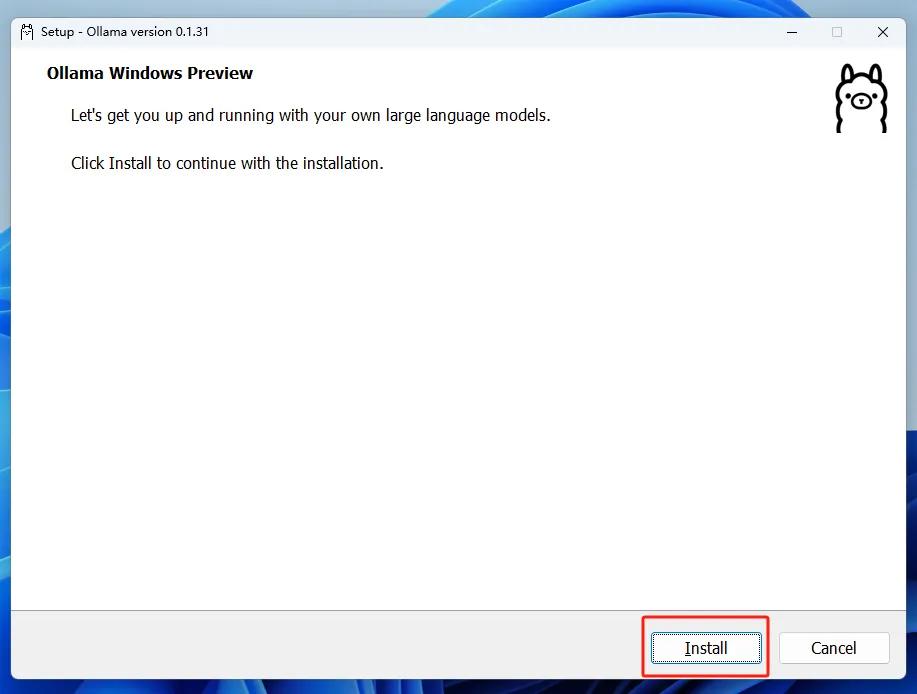

下载完成后,双击下载的安装程序

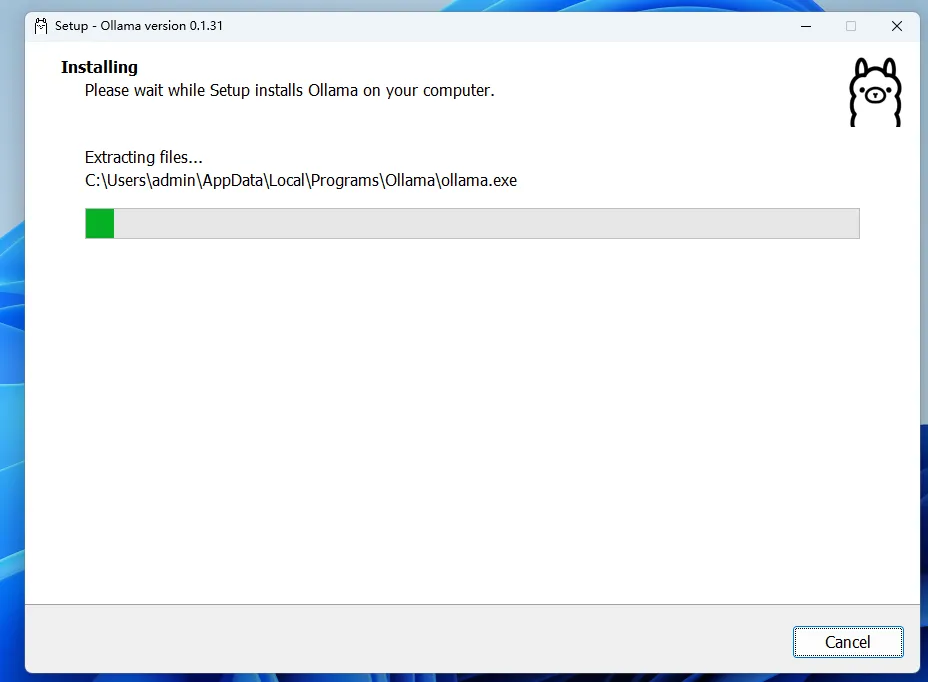

点击Install进行安装

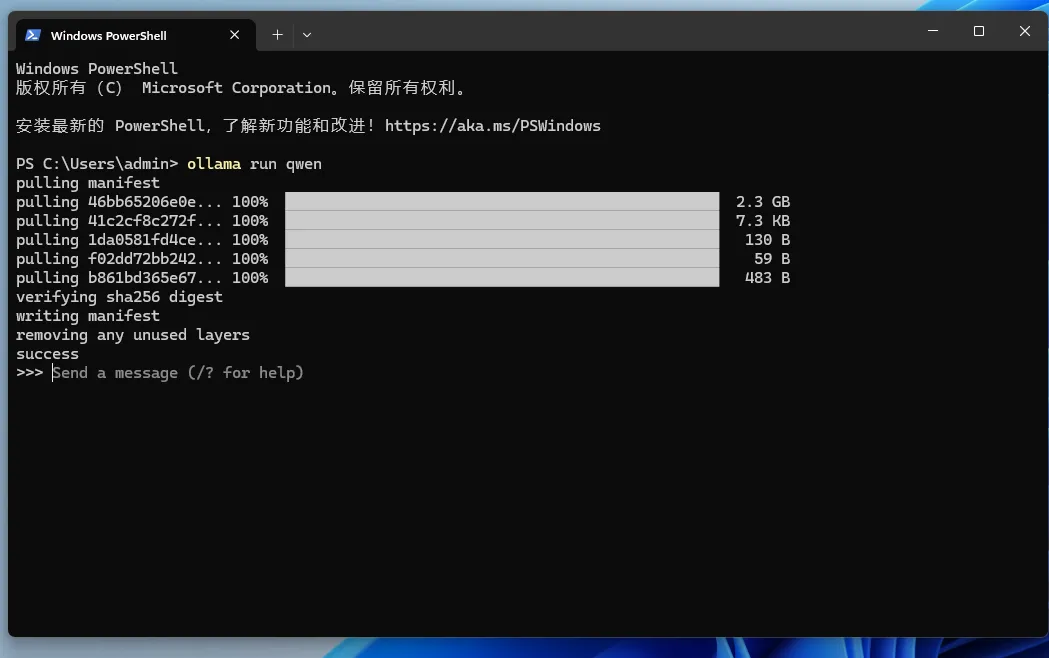

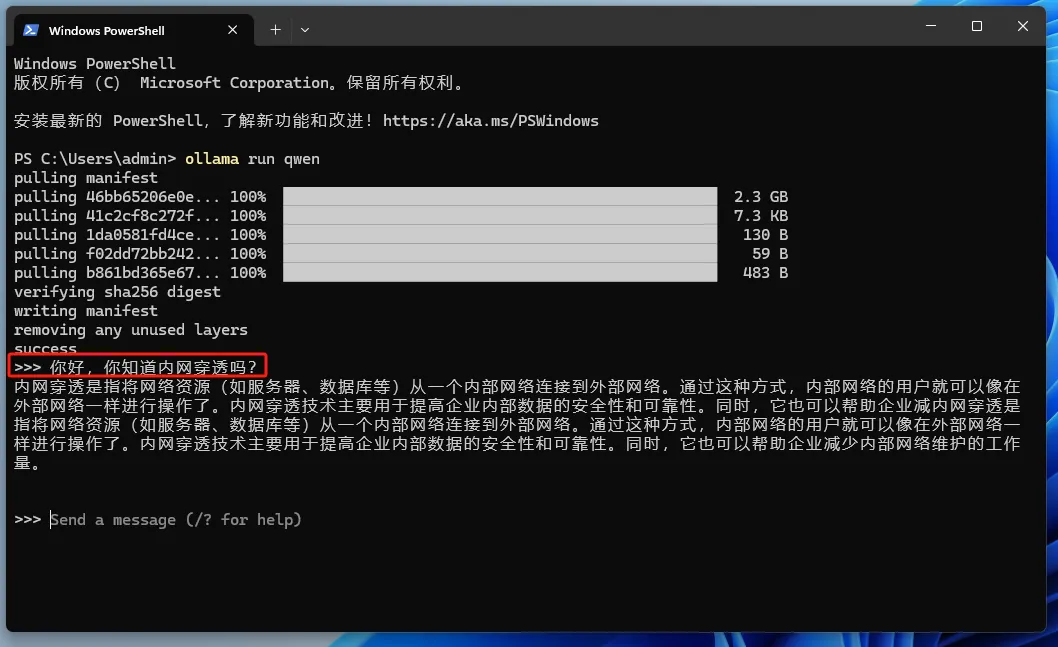

安装完成后,打开一个终端,在终端中输入下方命令运行一个大语言模型进行测试,这里以对在中文方面表现相对好些的千问为例:

ollama run qwen

首次运行时会先下载模型,下载完成后即可提问

模型下载完成后,我们就可以在终端中输入问题进行使用了:

到此为止,我们普通人也可以使用AI大模型进行问答了!!!

#Docker安装

①docker部署

# 只有CPU用这个docker run -itd --name ollama -v ollama:/root/.ollama -p 11434:11434 ollama/ollama# 有GPU用这个docker run -itd --name ollama --restart always --gpus=all -v /home/suxy/ollama:/root/.ollama -p 11434:11434 ollama/ollama

②拉取模型并运行

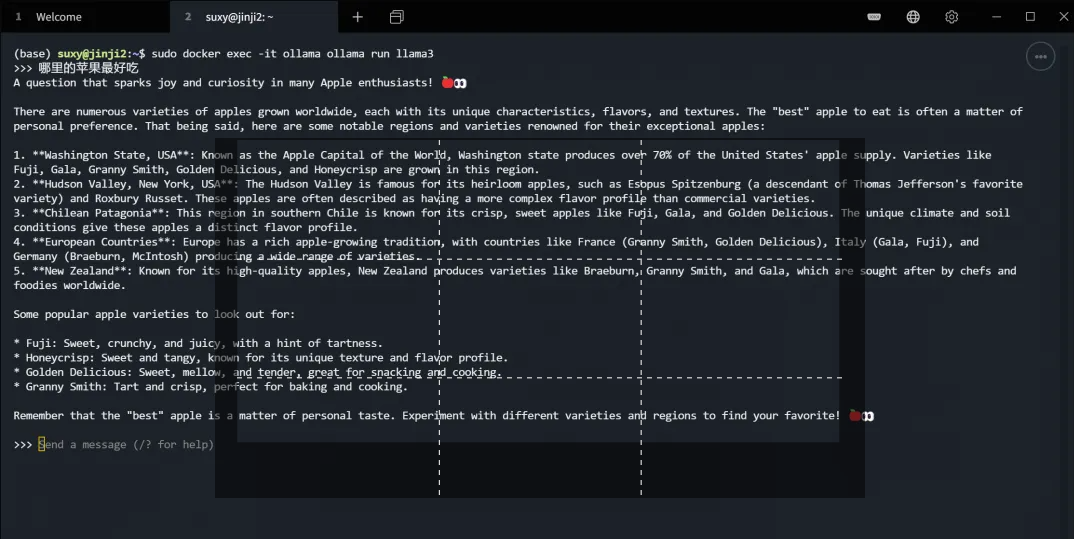

#千问4bdocker exec -it ollama ollama run qwen#llama3docker exec -it ollama ollama run llama3#gemmadocker exec -it ollama ollama run gemma

初次拉取模型,会先下载模型,模型下载完成后既可以进行对话交互,示例如下:

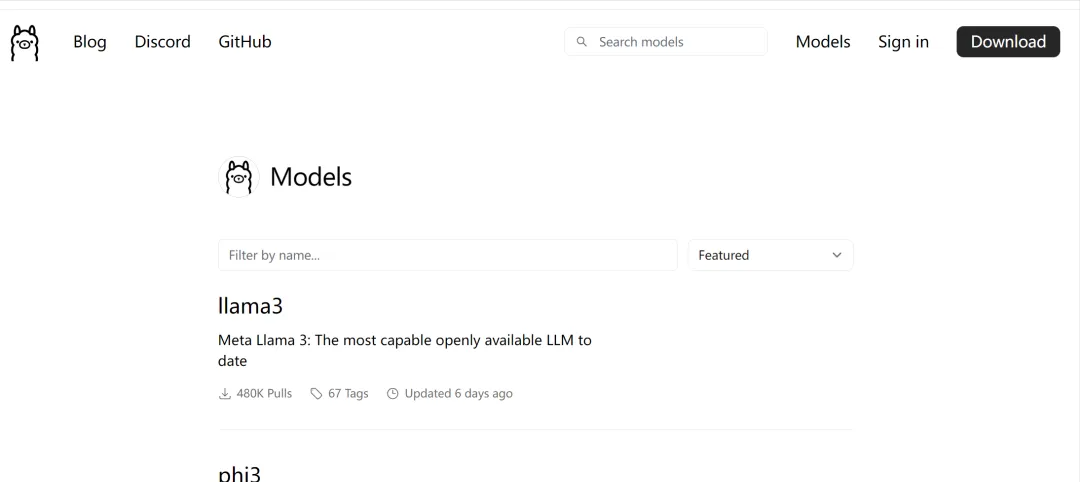

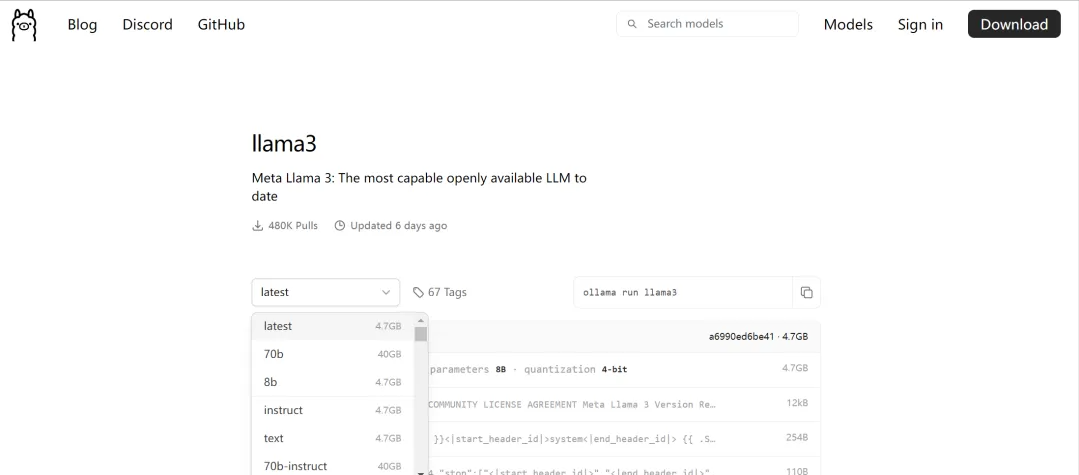

③其他模型

可以查看:https://ollama.ai/library

并可根据根据自身需求下载不同参数量级的模型

Open WebUI

上面只能在终端中使用,操作界面不像ChatGPT那样美观,如果能使用web页面进行交互,使用体验更好,也能保留之前的聊天记录,翻遍我们翻阅查询。

针对这个情况,部署Open WebUI这个项目即可实现类似chatgpt一样的交互界面。

本教程以Open WebUI这个项目为例,以前叫 Formerly Ollama WebUI,专门适配Ollama的WebUI

官方文档:https://docs.openwebui.com/getting-started/

Github:https://github.com/open-webui/open-webui

#docker快速部署

执行下面命令

#示例使用的是ollama-webuidocker run -itd --name ollama-webui --restart always -p 3500:8080 --add-host=host.docker.internal:host-gateway ghcr.io/ollama-webui/ollama-webui:latest#或docker run -itd --name open-webui --restart always -p 3500:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data ghcr.io/open-webui/open-webui:latest

部署成功后,浏览器打开连接:http://127.0.0.1:3500

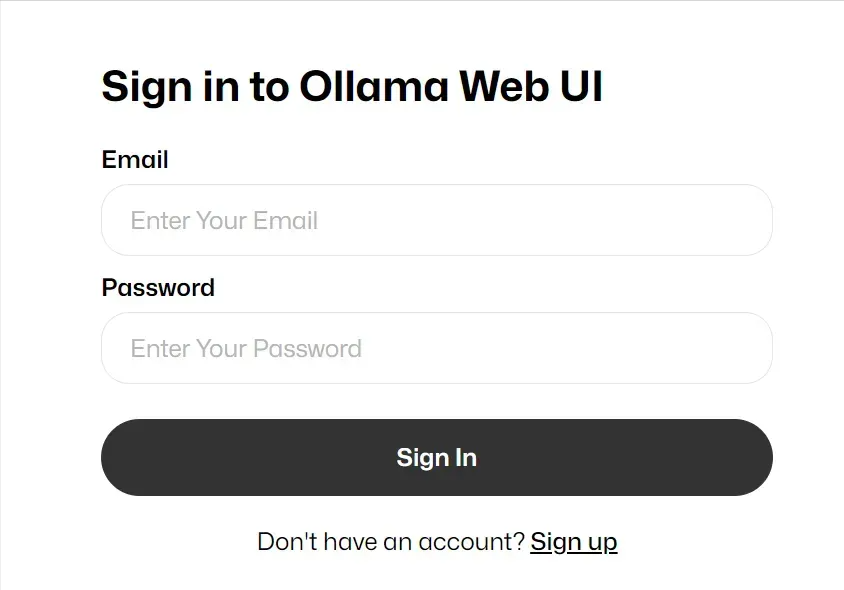

首次登录,先创建账号

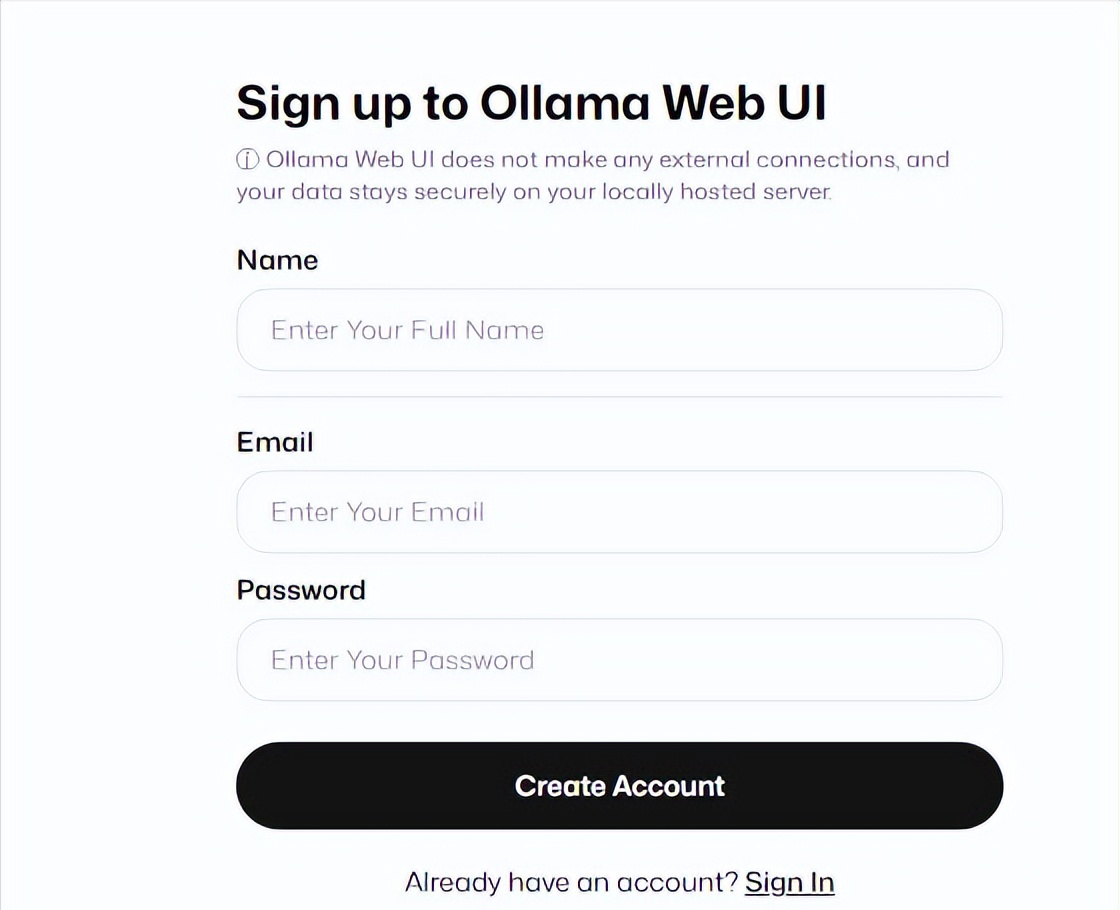

点击sign up注册,账号,邮箱,密码记好,下次登录时需要用到邮箱和密码登录:

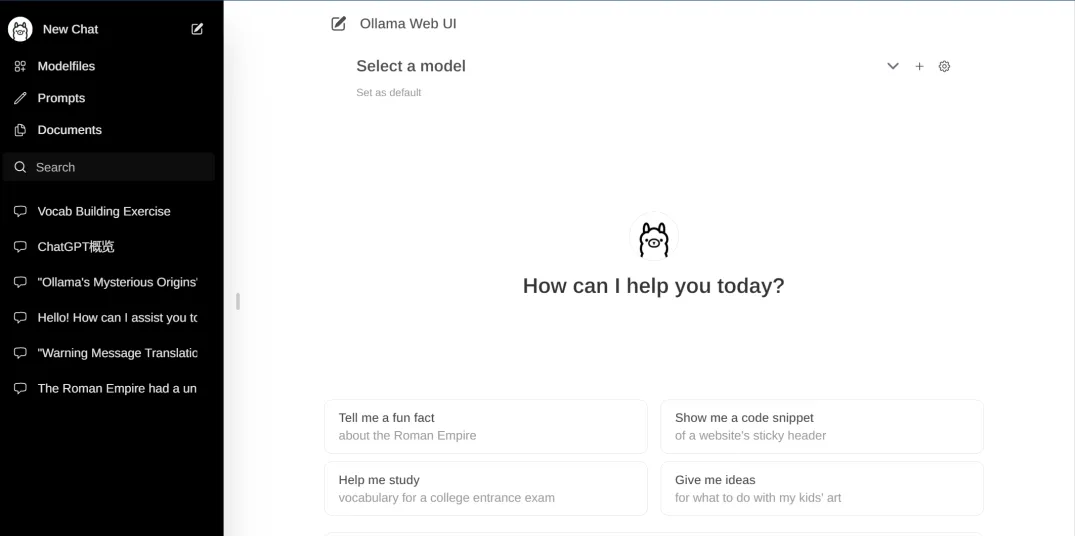

然后点击create account创建账号即可,然后就能在浏览器中使用类似chatgpt界面的Open WebUI了!

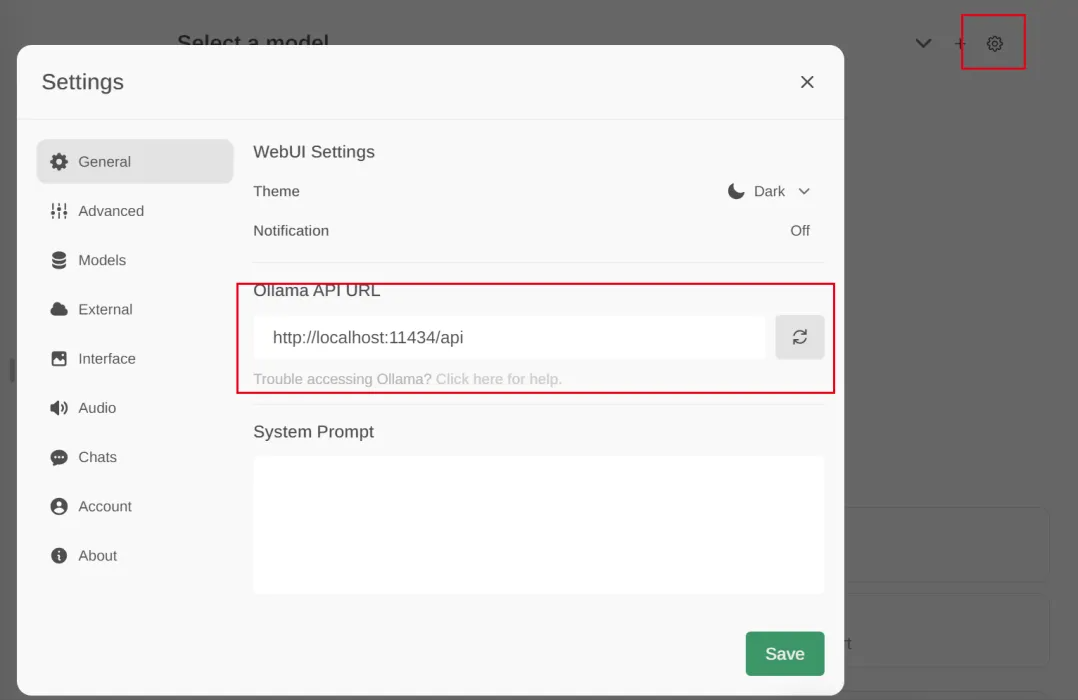

添加点击右上角的设置,设置上面安装的ollama服务,例如:http://localhost:11434/api

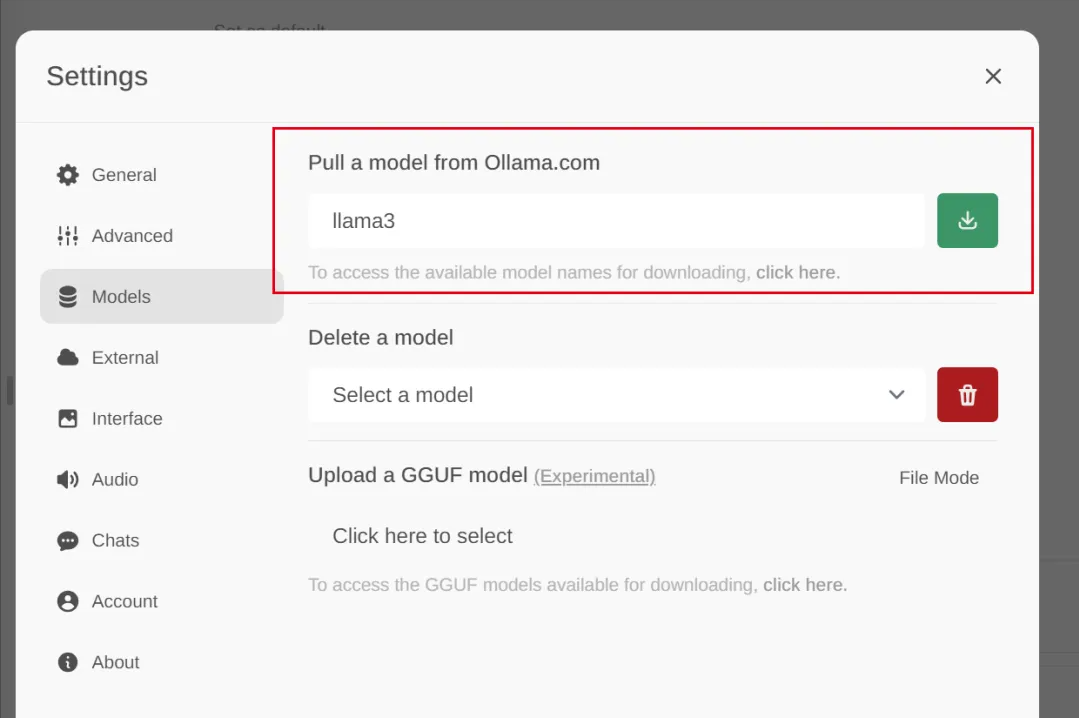

同时可以在页面下载想要安装的模型,点击下载按钮后,可见下载进度

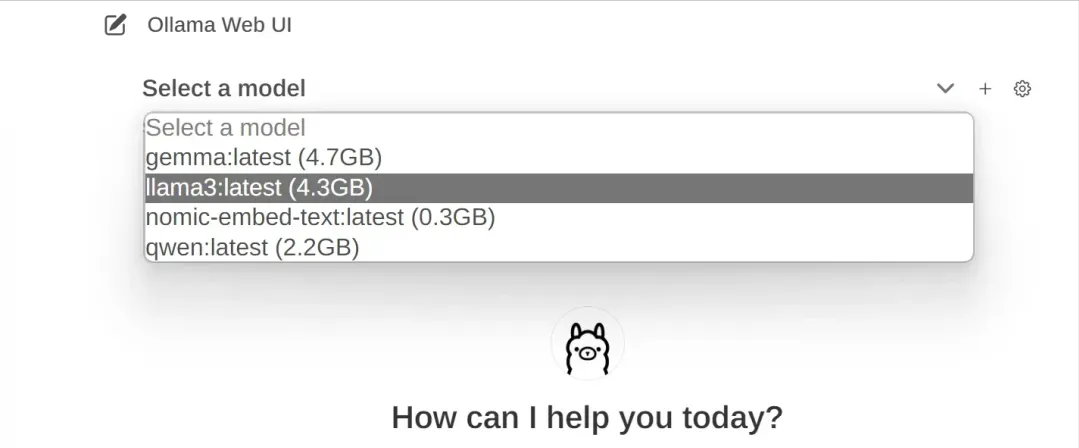

点击select a model,选择当前使用哪一个已安装的模型

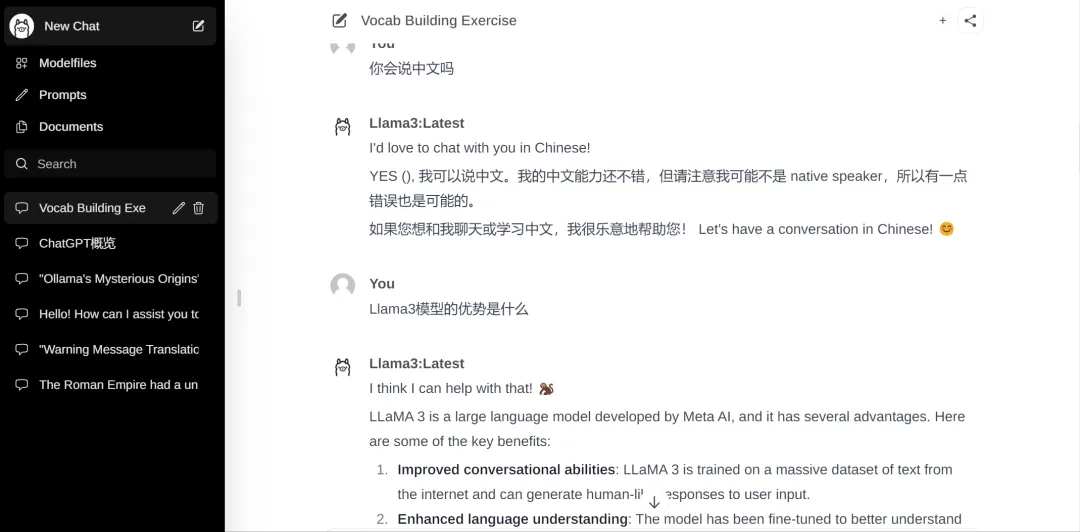

接下来就可以愉快的跟ai聊天了!

AnythingLLM

官方文档:https://docs.useanything.com/

Github:https://github.com/Mintplex-Labs/anything-llm

AnythingLLM 是一个基于RAG(Retrieval-Augmented Generation)方案构建的开源、高效、可定制的私有知识库解决方案。可以使用商业现成的 LLM 或流行的开源 LLM 和 vectorDB 解决方案来构建私有 ChatGPT

#下载安装AnythingLLM

官方安装教程:https://docs.useanything.com/anythingllm-desktop/windows-instructions

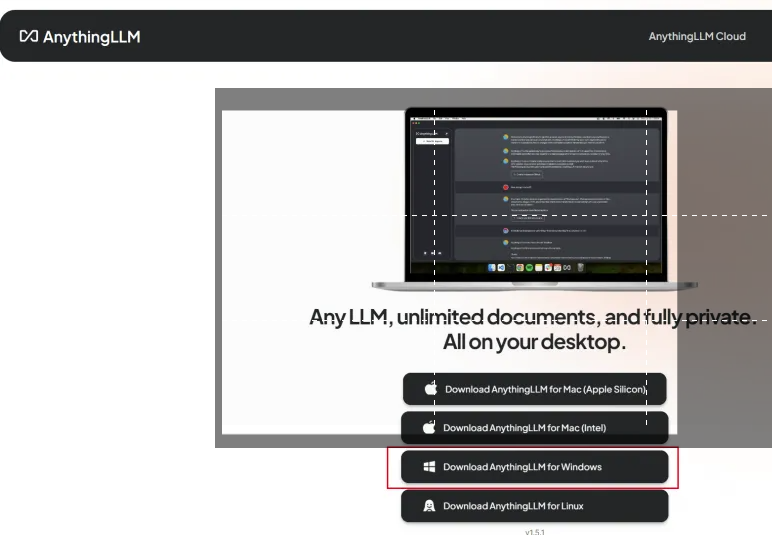

安装包下载地址:https://useanything.com/download

本示例以windows为例:

安装包下载完成后,双击安装包即可安装。

因为我已经配置过,所以不好截图最开始的配置界面,不过都能在设置里面找到

#配置LLM

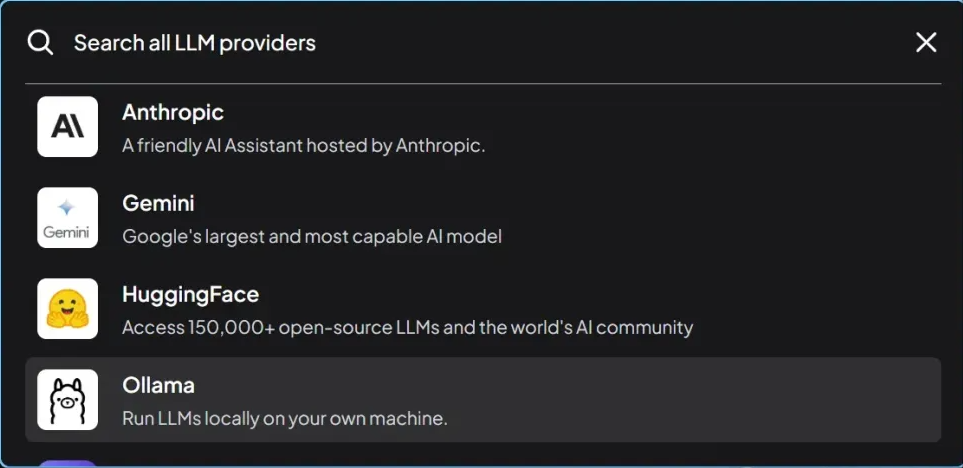

AnythingLLM支持的LLMs有OpenAI、LocalAi、Ollama等

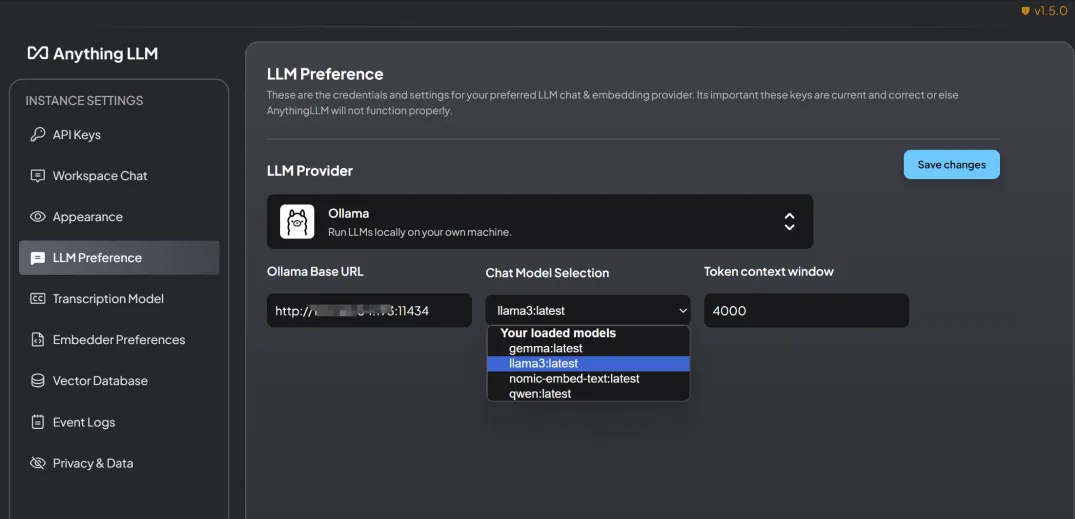

这里选择Ollama作为后台的服务,URL这里填写http://127.0.0.1:11434,也就是前面Ollama启动的服务端口,填写后LLM模型选择llama3

#配置EMbedding Model

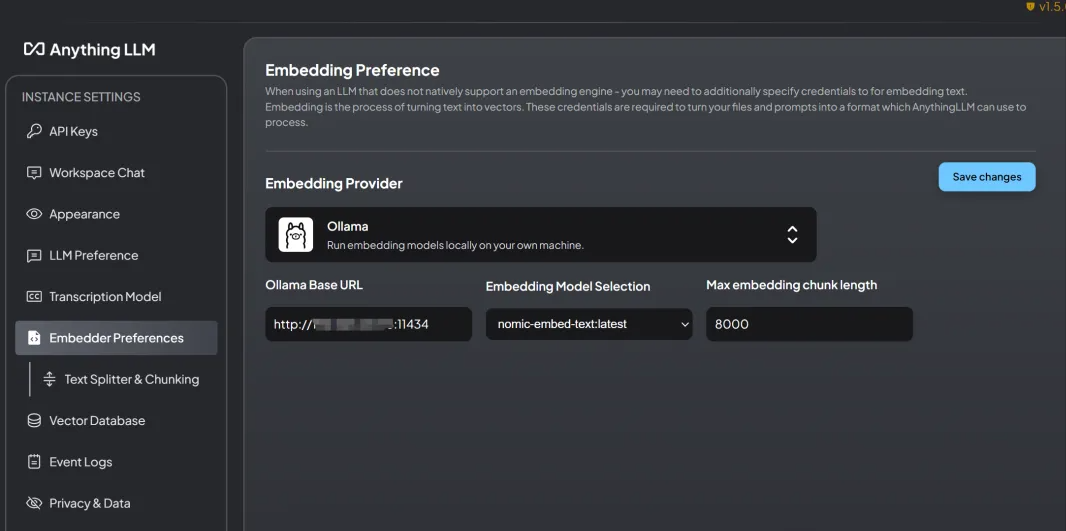

AnythingLLM支持的Embedding Model有:AnythingLLM Native Embedder (default),OpenAi,LocalAi、Ollama等

这里同样选择Ollama作为后台的服务,URL这里同样填写http://127.0.0.1:11434,填写后Embedding Model选择nomic-embed-text:latest:

#配置Vector Datebase

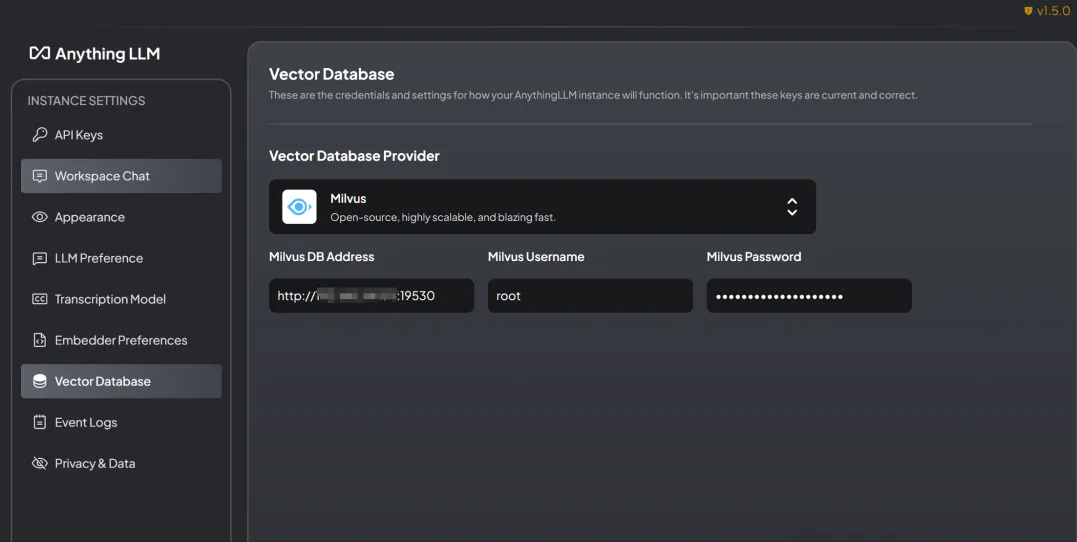

AnythingLLM支持的Vector Database有:LanceDB (default),Astra DB ,Pinecone ,Chroma ,Weaviate 、QDrant 、Milvus 、Zilliz等

以上三个关键配置完成后,就可以开始使用AnythingLLM了!!!

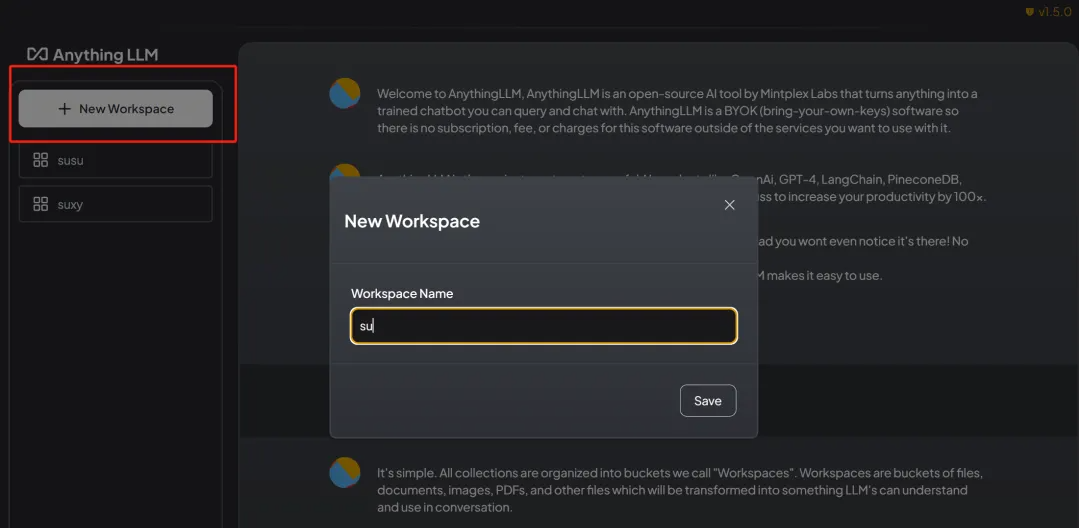

点击New Workspace新建文档库,并填写名称

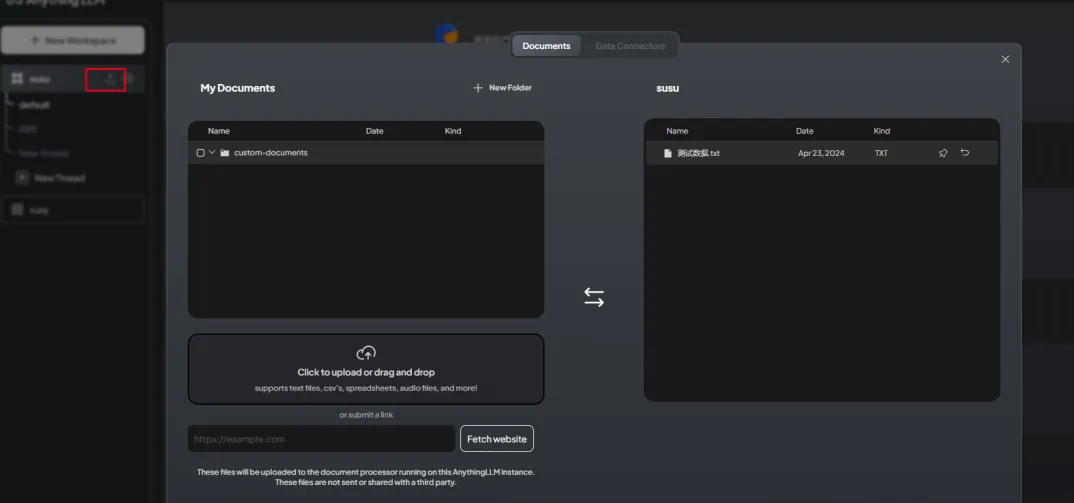

点击上传文件按钮开始添加文档:

下面就可以根据文档内容进行提问了