前有OpenAI发布GPT-4o,后有Google发布Imagen3,而现在,腾讯也交出了他的一份答卷:混元文生图大模型全面升级并开源!

这个是目前业内首个中文原生的DiT架构开源模型,并且支持中英文双语输入及理解。

什么是DiT架构呢?简单来说就是Stable diffusion3和Sora也是用的这种架构,但目前Sora并没有对外开放,而Stable diffusion3 也没有像之前说的完全开源,而混元大模型是完全开源的,从这一点看,我觉得腾讯混元团队还是非常有诚意的!(点个赞)

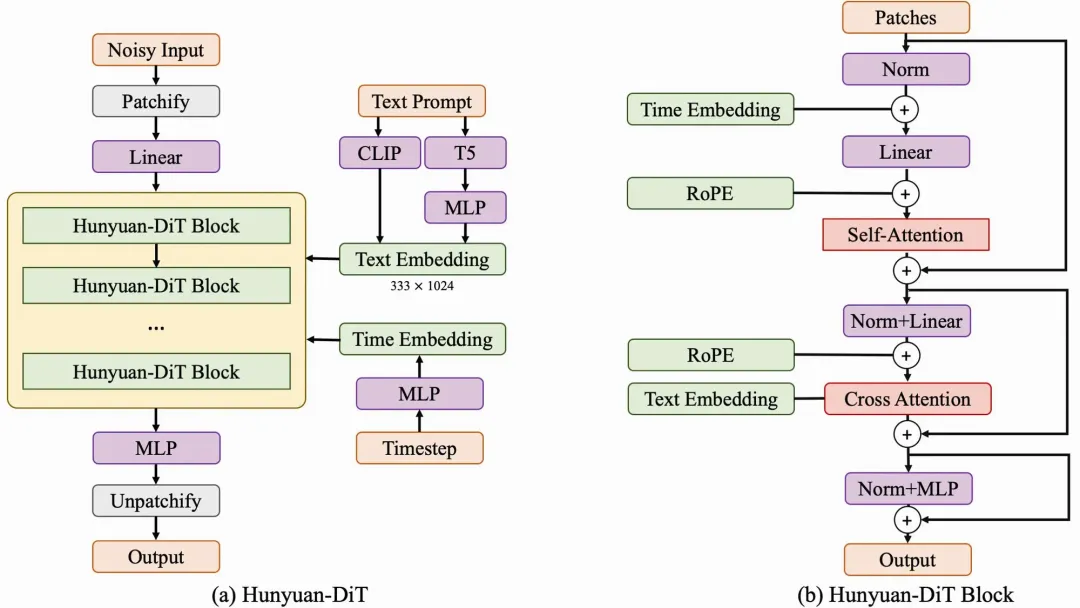

注:官方放出来的架构图,感兴趣可以看看,看不懂的可以让Kimi或者GPT4教你,实测有效

那么混元-DiT模型表现如何呢?请容我娓娓道来

1、支持中文提示词

前面提到,混元-DiT模型支持中英输入,所以对于国内的朋友是一个比较大的利好,不用再经历中文转英文的过程了。

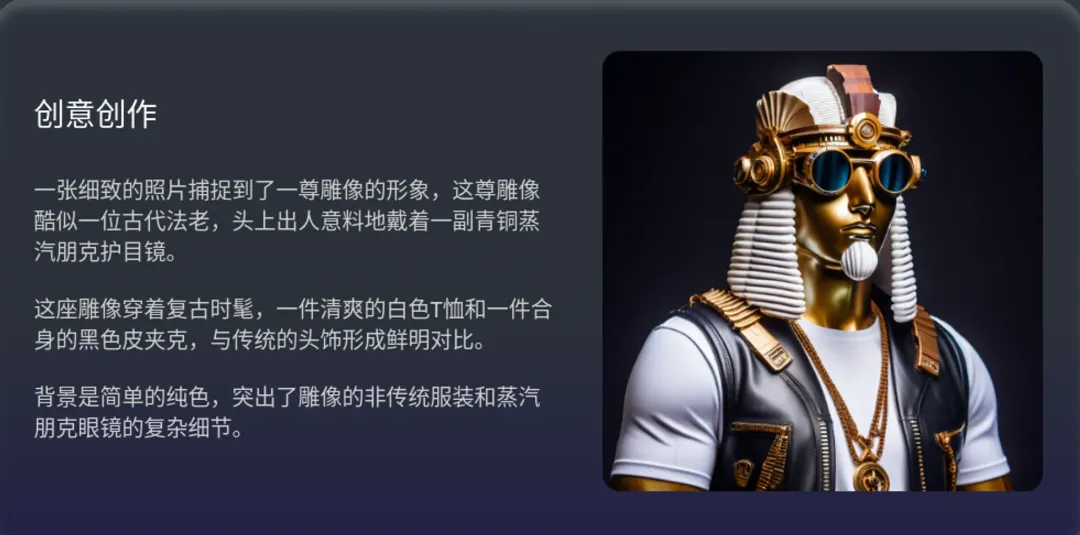

注:这是放出来的几张效果图

2、长文本理解能力

简单来说就是能分析和理解长篇文本中的信息并生成相应艺术作品,这是官方放出来的效果图

3、支持多轮对话

也就是说可以通过多次对话来不断修改图片,从而达到我们的要求,毕竟有时候一次对话并不能很好地生成满意的图片。

如果你看我之前介绍文生视频工具Pika的文章,可能你对这个功能就不会陌生,因为Pika也是支持多轮对话修改视频的。

那么混元-DiT模型如何体验呢?很遗憾,目前的话,我并没有找到能够在线体验的地方!

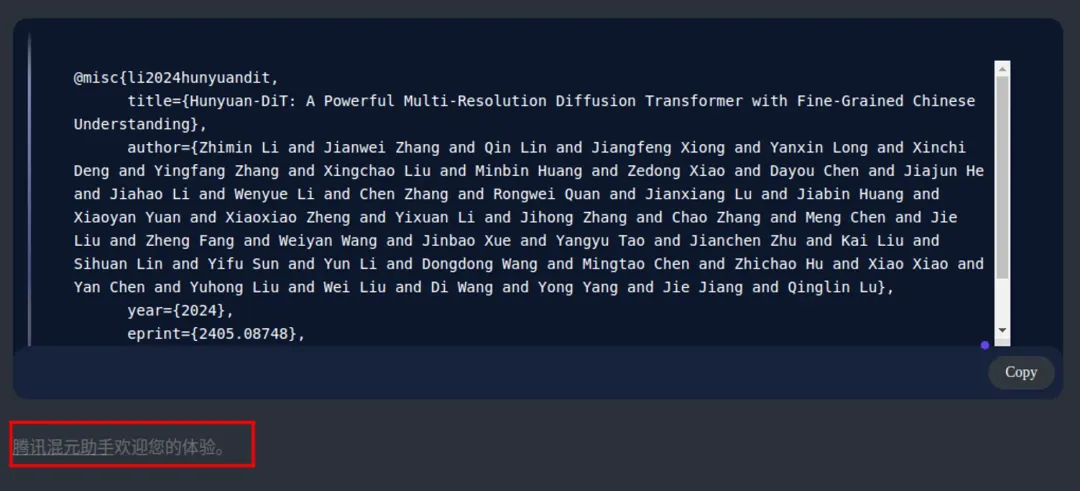

虽然在混元-DiT模型的官网提到了欢迎你在腾讯混元助手体验,但是我登录进去之后,发现里面的模型并不是新开源的这个(还是说我不在灰度?),原因有三个:

第一是它的底部标明了是基于腾讯混元大模型V1.7.6,并且消息中心也没有最新的开源消息

第二就是官方放出来的视频中,我看到演示的版本其实是2.0

第三就是凭感觉了,在混元助手里面生成的图片明显感觉没有官网放出来的好,而且还需要“生成一张图片”等提示词触发。

所以如果想体验的话,只能参照Github上的说明安装并体验了,刚好我的电脑配置也满足要求,后续会单独出一期教学

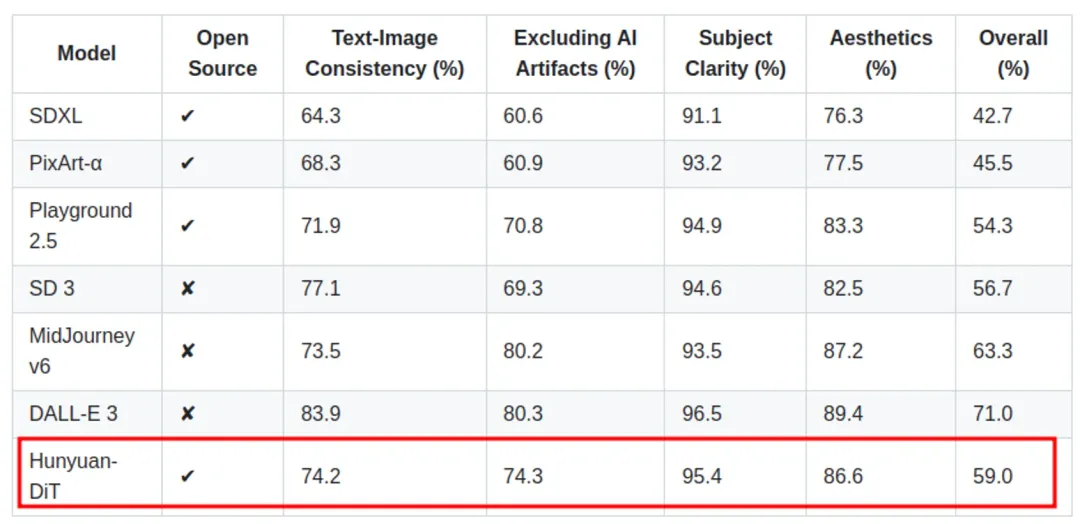

最后在说说它和其他文生图模型的比较,这是Github上放出来的测试对比:

注:这是由50多名专业评测人员进行评测的结果

总体来讲,相对于其他开源模型是有所提升的,但是对于一些闭源模型就仍有差距,希望在开源的力量下变得更好!

相关地址:

混元-DiT官网:https://dit.hunyuan.tencent.com/

混元-DiT Github地址:https://github.com/Tencent/HunyuanDiT

混元助手地址:https://www.1ai.net/6765.html