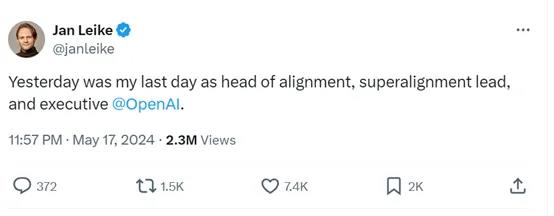

5月18日凌晨,OpenAI安全主管、超级对齐负责人Jan Leike在社交平台宣布,离开OpenAI。

这也是本周三OpenAI联合创始人兼首席科学家Ilya Sutskever辞职之后,又有一名高管辞职。

相信随着二人的离开,后续还会有不少人离开OpenAI。这也标志着去年由Ilya发起的“罢免Sam Altman” 事件以失败落幕。

OpenAI首席执行官Sam Altman在第一时间给出了回应,感谢并肯定了Jan在OpenAI的贡献和领导能力。

并表示,未来几天内会发表一篇更长的文章,来阐述OpenAI对于产品安全的规划和所做的事情。

Jan在辞职演讲中表示,他加入OpenAI是因为,OpenAI是全世界最适合做大模型安全研究的公司。

但是,OpenAI的高层领导似乎对安全对齐已经不是那么上心了,直到爆发了无法挽回的局面,所以,是时候离开了。

他也承认,构建比人类更聪明的AI机器人是一项非常危险的事情,不想看到《终结者》、《机械公敌》那种科幻电影变成现实,机器人失控并开始清理人类。

OpenAI正在代表整个人类肩负着巨大的责任,向AGI(通用人工智能)砥砺前进。

应该将更多的算力、基础设施用于产品的安全、对抗鲁棒性、超级对齐、数据保密、监控等领域。

所以,OpenAI应该是以安全为主的AGI公司,而不是一味的发布一些没有安全保证的危险产品。

对于Ilya、Jan的辞职,有人表示这两位安全领导高管都辞职了,以后谁来负责OpenAI的产品安全呢?

也有一位网友爆料,想离开OpenAI没问题,但是你必须签署一份“离职协议”,如果你不签署终身不诋毁承诺,将失去所有已获得的OpenAI股权。

不知道Jan的一番吐槽,是否会影响到他的股权。

虽然本周OpenAI发布了再一次震惊科技圈的多模态大模型GPT4o,但内部人事也迎来了大变革,可能会对未来的产品发布例如,GPT-5等带来一些不确定的因素。

2023年11月18,Ilya认为Sam的产品路线出现了大问题,太激进完全不顾产品的安全性,随后发动了震惊全球科技界的“罢免Sam Altman” 事件。

经过十多天周旋之后,Sam在微软的强力帮助下重新回到了OpenAI执掌大权。

如今,Ilya等人已经辞职,没了捆龙锁的Sam会在AGI的道路继续狂飙吗?让我们拭目以待吧。

关于Jan Leike

加入OpenAI之前,Jan曾在谷歌DeepMind工作,主要负责从人类反馈中进行强化学习的原型设计。在OpenAI期间,参与了InstructGPT、ChatGPT的开发以及GPT-4的安全对齐工作。

Jan曾发表了《Weak-to-Strong Generalization: Eliciting Strong Capabilities With Weak Supervision》、《Self-critiquing models for assisting human evaluators》、《Deep Reinforcement Learning from Human Preferences》等多篇知名大模型安全论文。

2023年,Jan 被《时代》周刊评为AI领域最具影响力的100位人物之一。